来源:新智元

开源先锋StabilityAI一天扔了两枚重磅炸弹:发布史上首个开源RLHF大语言模型,以及像素级图像模型DeepFloydIF。开源社区狂喜!

最近,大名鼎鼎的StableDiffusion背后的公司,一连整了两个大活。

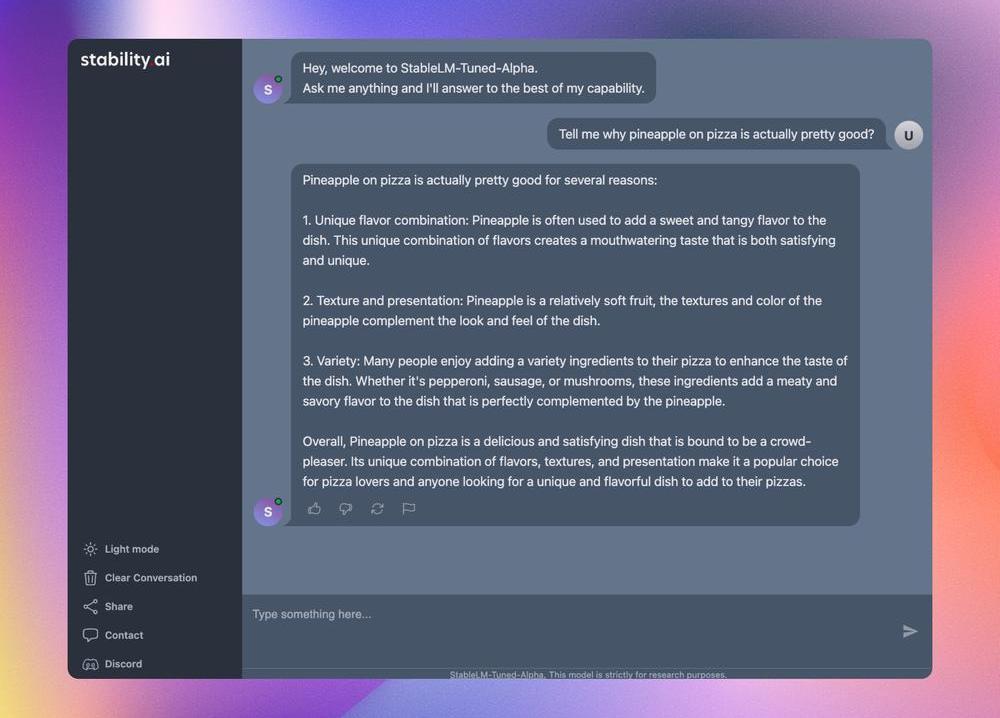

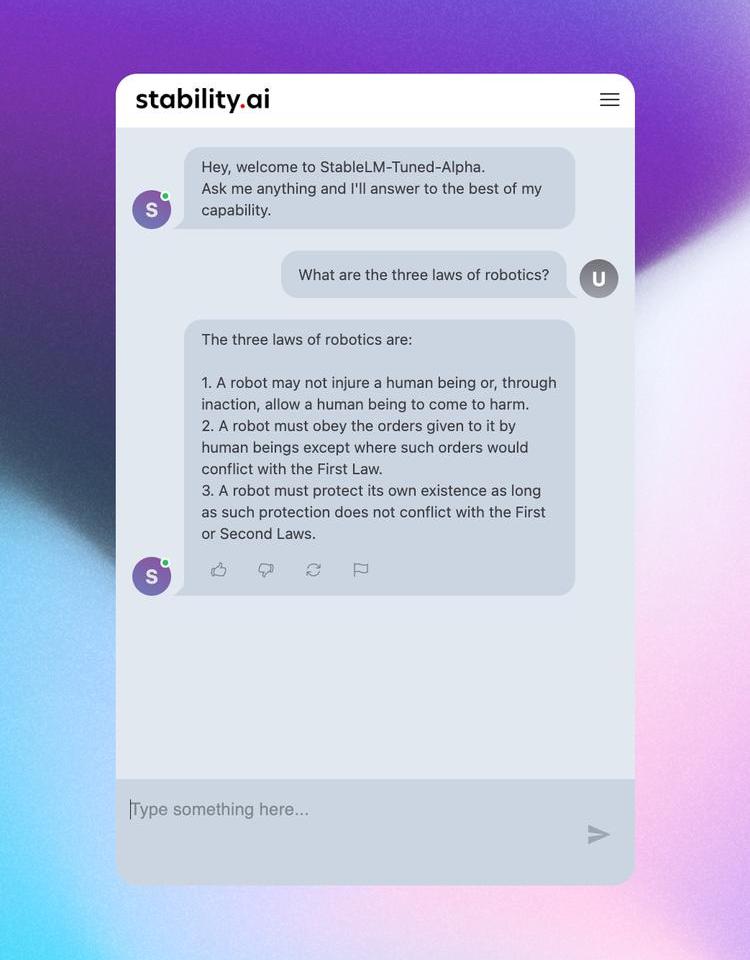

首先,StabilityAI重磅发布了世上首个基于RLHF的开源LLM聊天机器人——StableVicuna。

StableVicuna基于Vicuna-13B模型实现,是第一个使用人类反馈训练的大规模开源聊天机器人。

有网友经过实测后表示,StableVicuna就是目前当之无愧的13BLLM之王!

对此,1xexited创始人表示,这可以看作是自ChatGPT推出以来的第二个里程碑。

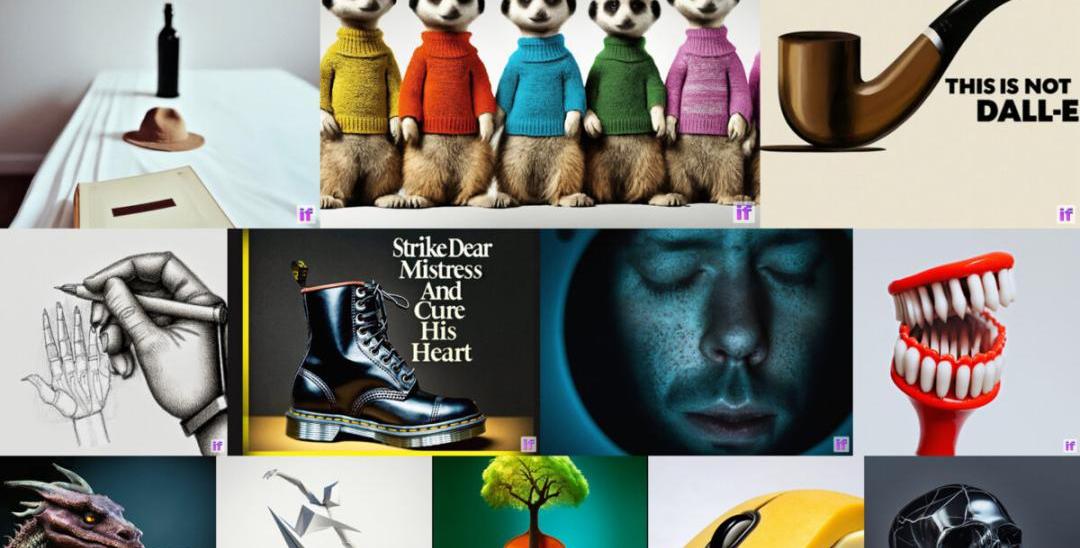

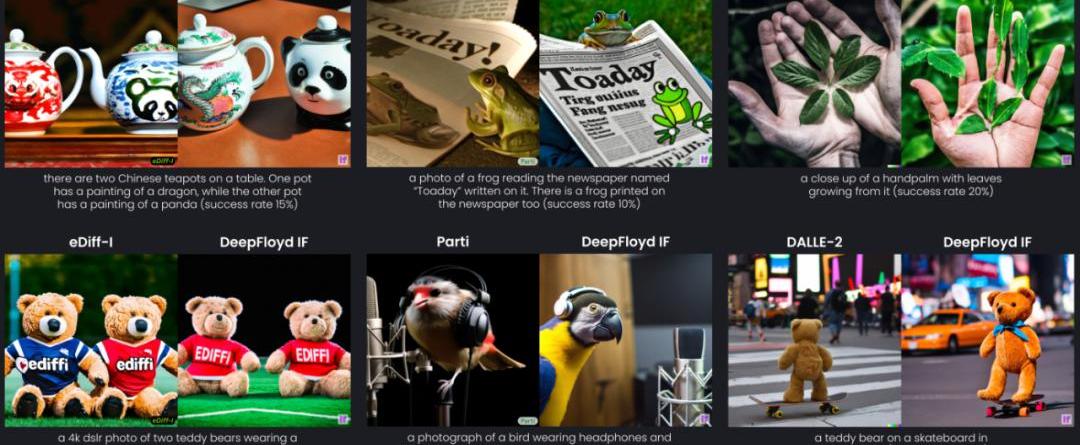

另外,StabilityAI发布了开源模型DeepFloydIF,这个文本到图像的级联像素扩散模型功能超强,可以巧妙地把文本集成到图像中。

这个模型的革命性意义在于,它一连解决了文生图领域的两大难题:正确生成文字,正确理解空间关系!

秉持着开源的一贯传统,DeepFloydIF在以后会完全开源。

StailibityAI,果然是开源界当之无愧的扛把子。

StableVicuna

世上首个开源RLHFLLM聊天机器人StableVicuna,由StabilityAI震撼发布!

数据:算法Stablecoin MIM短时脱锚至0.9465美元:11月8日消息,据Chainlink实时数据显示,算法StablecoinMIM价格短时脱锚至0.9465美元,现报0.9813美元。[2022/11/8 12:31:47]

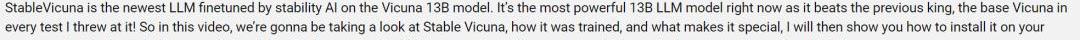

一位Youtube主播对StableVicuna进行了实测,StableVicuna在每一次测试中,都击败了前任王者Vicuna。

所以这位Youtuber激动地喊出:StableVicuna就是目前最强大的13BLLM模型,是当之无愧的LLM模型之王!

StableVicuna基于小羊驼Vicuna-13B模型实现,是Vicuna-13B的进一步指令微调和RLHF训练的版本。

而Vicuna-13B是LLaMA-13B的一个指令微调模型。

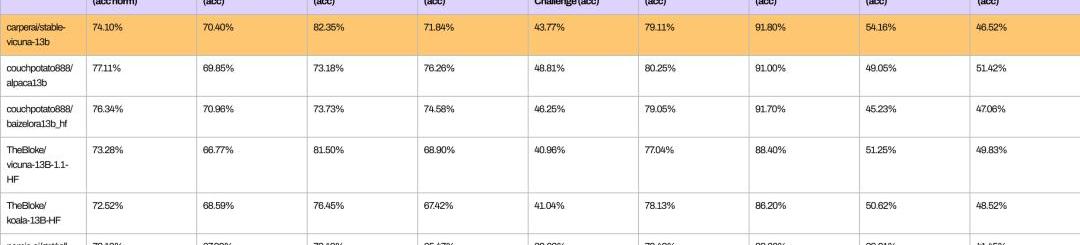

从以下基准测试可以看出,StableVicuna与类似规模的开源聊天机器人在整体性能上的比较。

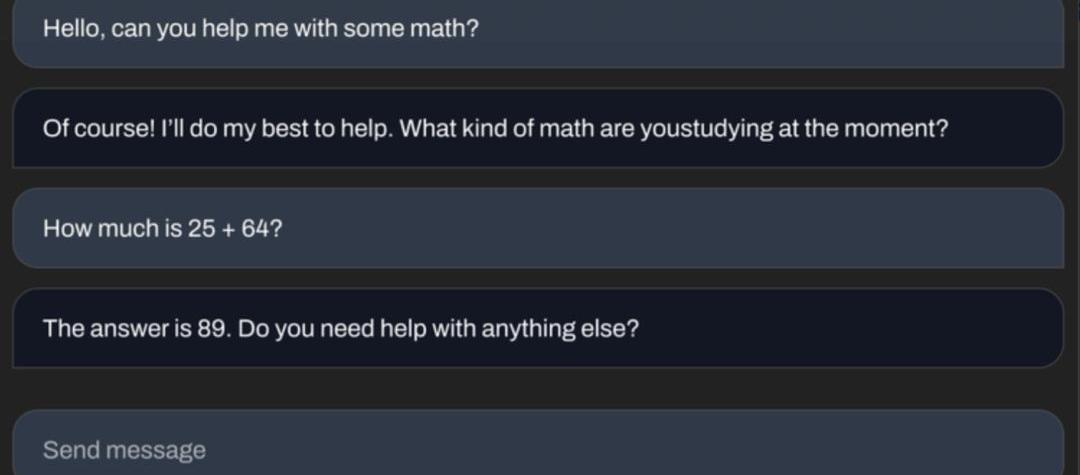

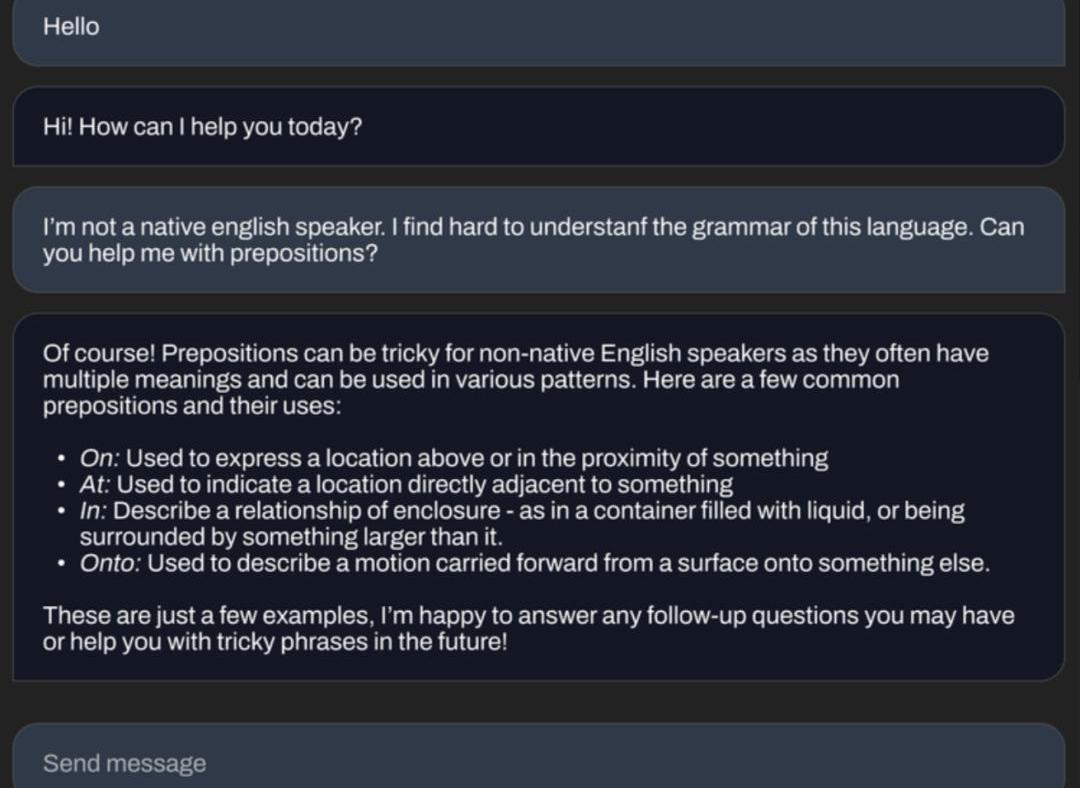

StableVicuna可以做基础数学题。

乌克兰与 FTX、Everstake 合作推出新的加密货币捐赠网站:金色财经报道,乌克兰政府周一推出了一个新的加密货币捐赠网站,旨在简化将比特币转化为子弹、绷带和其他战争物资的数百万美元努力。Everstake的增长主管Vlad Likhuta称,援助乌克兰 得到了FTX、Everstake平台和乌克兰的Kuna交易所的支持,它将把捐赠的加密货币送到乌克兰国家银行。乌克兰精通加密货币的数字转型部门也参与其中。

根据该网站,该国的努力已经筹集了约4800万美元的比特币、Polkadot、以太坊、Solana、Tether和其他加密货币。其他估计认为总数接近1亿美元。(Coindesk)[2022/3/15 13:56:22]

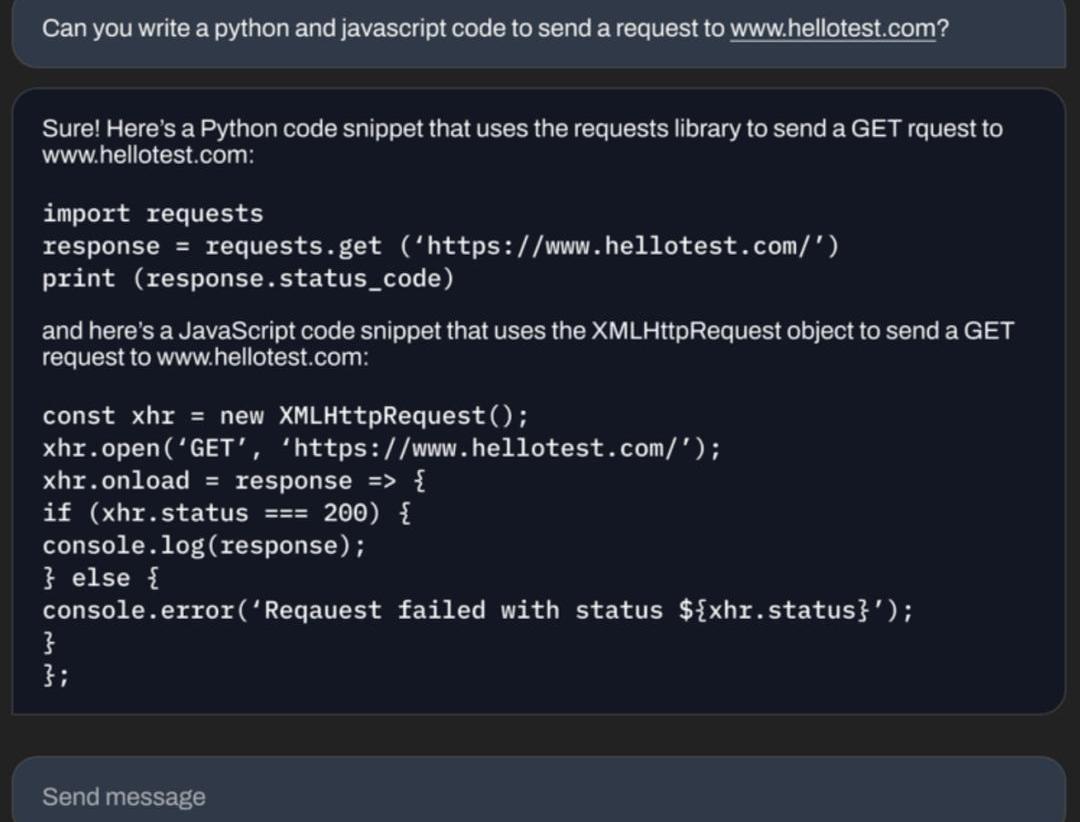

可以写代码。

还能为你讲解语法知识。

开源聊天机器人平替狂潮

StabilityAI想做这样一个开源的聊天机器人,当然也是受了此前LLaMa权重泄露引爆的ChatGPT平替狂潮的影响。

从去年春天Character.ai的聊天机器人,到后来的ChatGPT和Bard,都引发了大家对开源平替的强烈兴趣。

这些聊天模型的成功,基本都归功于这两种训练范式:指令微调和人类反馈强化学习(RLHF)。

这期间,开发者一直在努力构建开源框架帮助训练这些模型,比如trlX、trl、DeepSpeedChat和ColossalAI等,然而,却并没有一个开源模型,能够同时应用指令微调和RLHF。

大多数模型都是在没有RLHF的情况下进行指令微调的,因为这个过程十分复杂。

最近,OpenAssistant、Anthropic和Stanford都开始向公众提供RLHF数据集。

StabilityAI把这些数据集与trlX提供的RLHF相结合,就得到了史上第一个大规模指令微调和RLHF模型——StableVicuna。

训练过程

为了实现StableVicuna的强大性能,研究者利用Vicuna作为基础模型,并遵循了一种典型的三级RLHF管线。

Enjin:Substack上出现假冒Enjin的账户,请注意防范:区块链游戏开发平台Enjin在推特上表示,Substack上出现了假冒Enjin并宣传虚假智能合约升级的账户。请不要与此帐户交互,我们永远不会要求用户向我们提供资金或分享敏感信息。请保持警惕。[2021/4/24 20:54:36]

Vicuna在130亿参数LLaMA模型的基础上,使用Alpaca进行调整后得到的。

他们混合了三个数据集,训练出具有监督微调(SFT)的Vicuna基础模型:

OpenAssistantConversationsDataset(OASST1),一个人工生成的、人工注释的助理式对话语料库,包含161,443条消息,分布在66,497个对话树中,使用35种不同的语言;

GPT4AllPromptGenerations,由GPT-3.5Turbo生成的437,605个提示和响应的数据集;

Alpaca,这是由OpenAI的text-davinci-003引擎生成,包含52,000条指令和演示的数据集。

研究者使用trlx,训练了一个奖励模型。在以下这些RLHF偏好数据集上,研究者得到了SFT模型,这是奖励模型的基础。

OpenAssistantConversationsDataset(OASST1),包含7213个偏好样本;

AnthropicHH-RLHF,一个关于AI助手有用性和无害性的偏好数据集,包含160,800个人类标签;

斯坦福人类偏好(SHP),这是一个数据集,包含348,718个人类对各种不同回答的集体偏好,包括18个从烹饪到哲学的不同学科领域。

最后,研究者使用了trlX,进行近端策略优化(ProximalPolicyOptimization,PPO)强化学习,对SFT模型进行了RLHF训练,然后,StableVicuna就诞生了!

据StabilityAI称,会进一步开发StableVicuna,并且会很快在Discord上推出。

另外,StabilityAI还计划给StableVicuna一个聊天界面,目前正在开发中。

动态 | Bitstamp CEO:比特币网络以一杯咖啡的价格转移了10亿美元:加密货币交易所Bitstamp的首席执行官强调了比特币(BTC)的效用,此前价值近10亿美元的资金以不到4美元的手续费易手,这些资金“以一杯咖啡的价格在一笔交易中转移了”。正如区块链监控资源BitInfoCharts于10月14日确认的那样,在钱包和存储提供商Xapo进行的交易总计112,027.29 BTC。此前,Bitstamp已将其约107,800 BTC的资金转移到Xapo,支付的费用为0.0234 BTC或0.0000217%。(Cointelegraph)[2019/10/15]

相关演示已经可以在HuggingFace上查看了,开发者也可以在HuggingFace上下载模型的权重,作为原始LLaMA模型的增量。

但如果想使用StableVicuna,还需要获得原始LLaMA模型的访问权限。

获得权重增量和LLaMA权重后,使用GitHub存储库中提供的脚本将它们组合起来,就能得到StableVicuna-13B了。不过,也是不允许商用的。

DeepFloydIF

在同一时间,StabilityAI还放出了一个大动作。

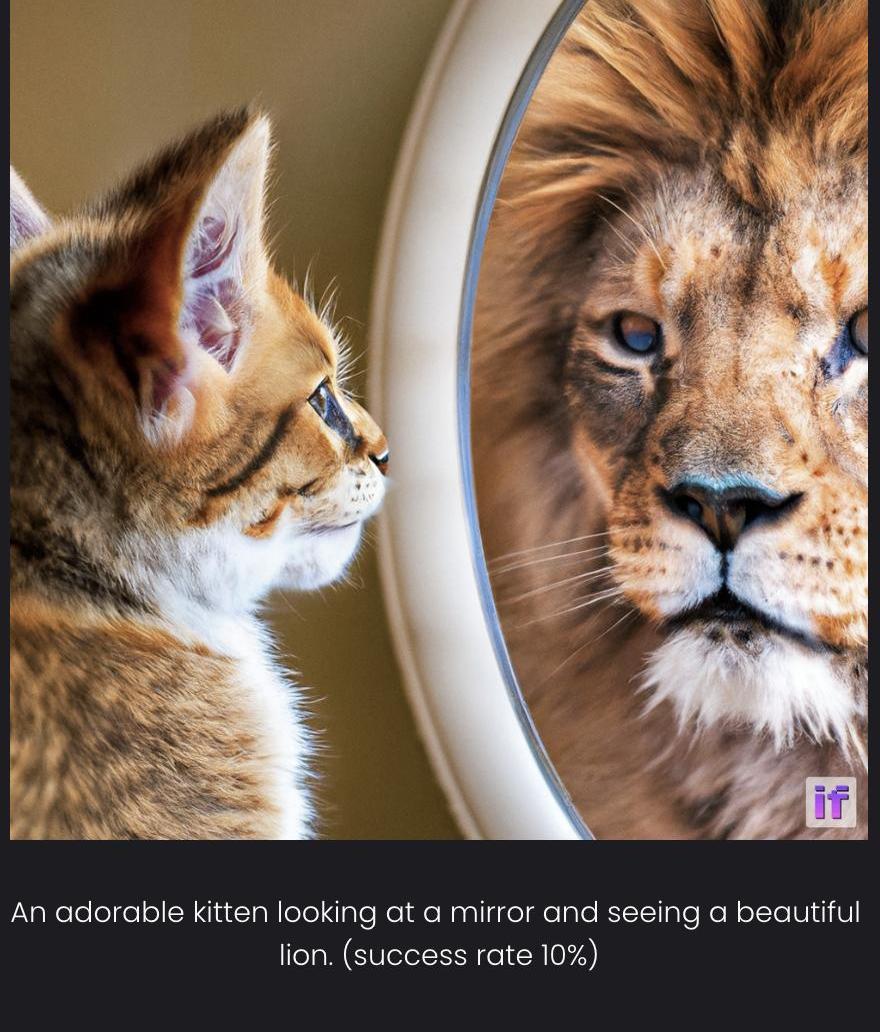

你敢信,AI一直无法正确生成文字这个老大难问题,竟然被解决了?

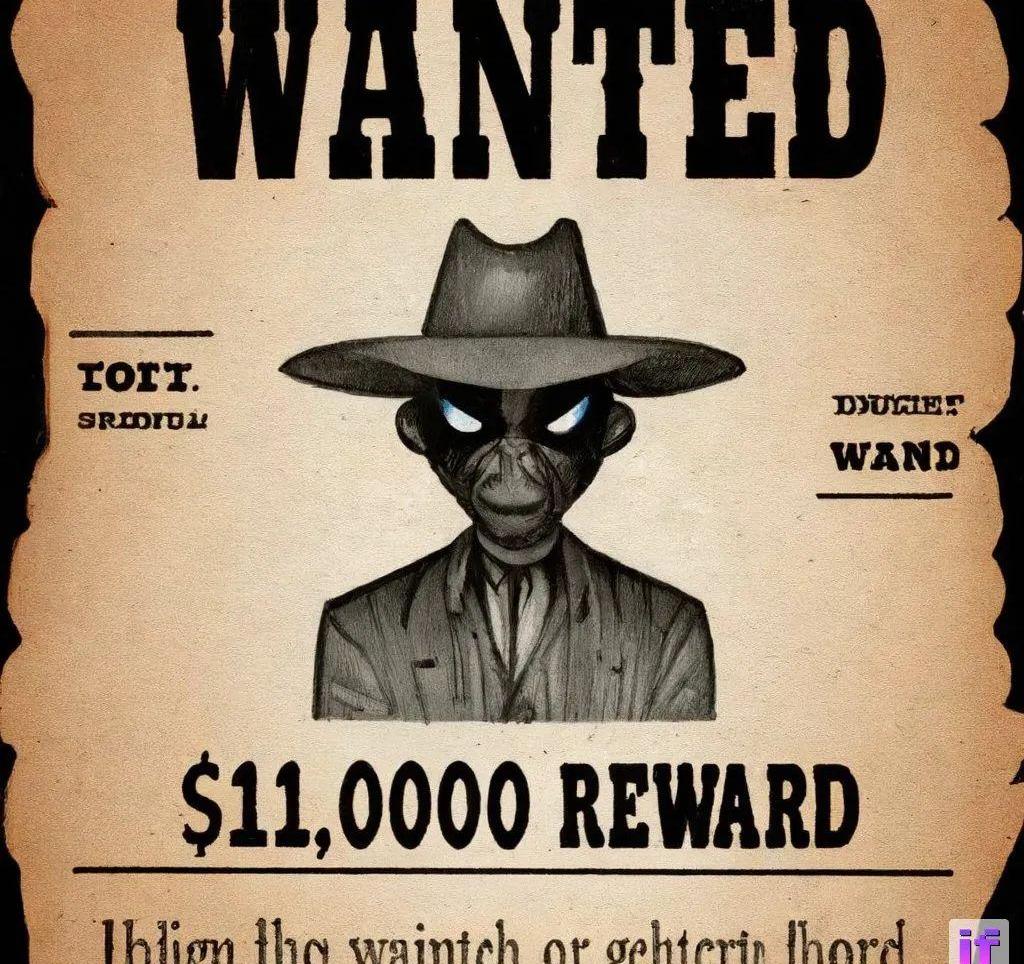

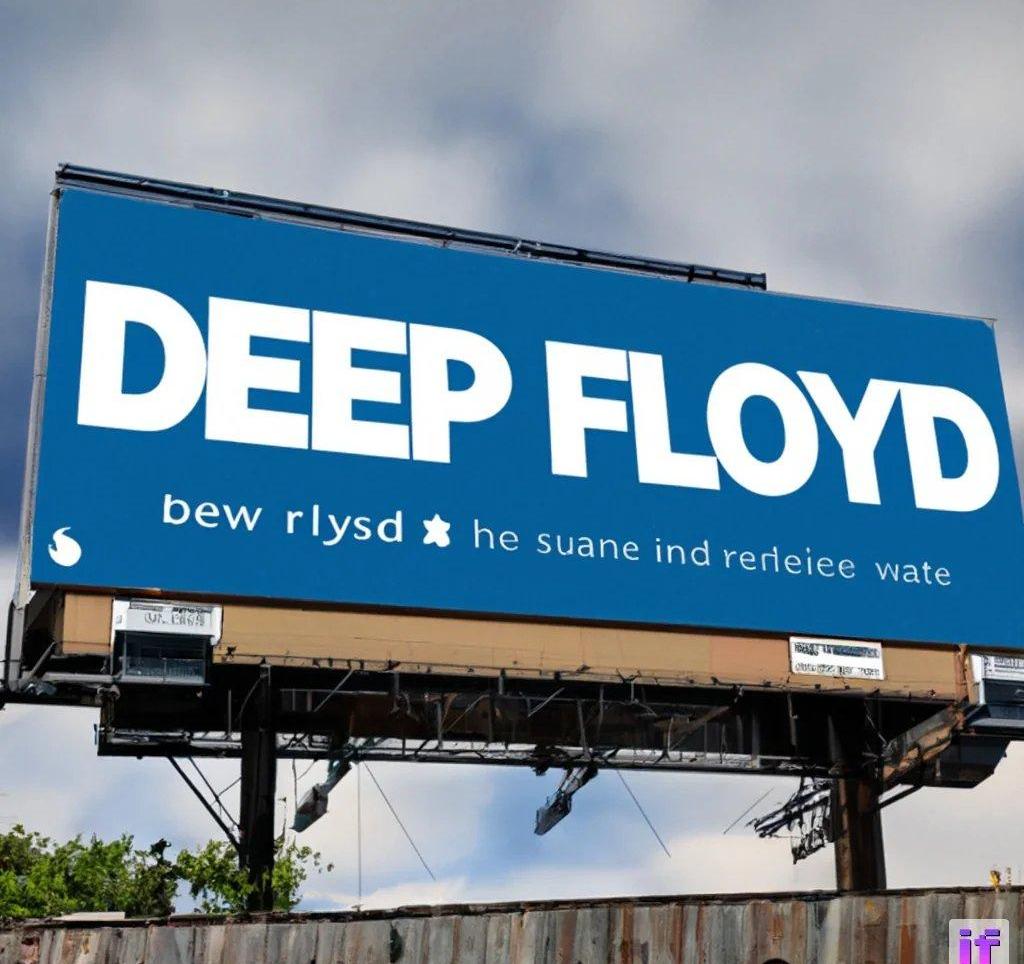

没错,下面这张「完美」的招牌,就是由StabilityAI全新推出的开源图像生成模型——DeepFloydIF制作的。

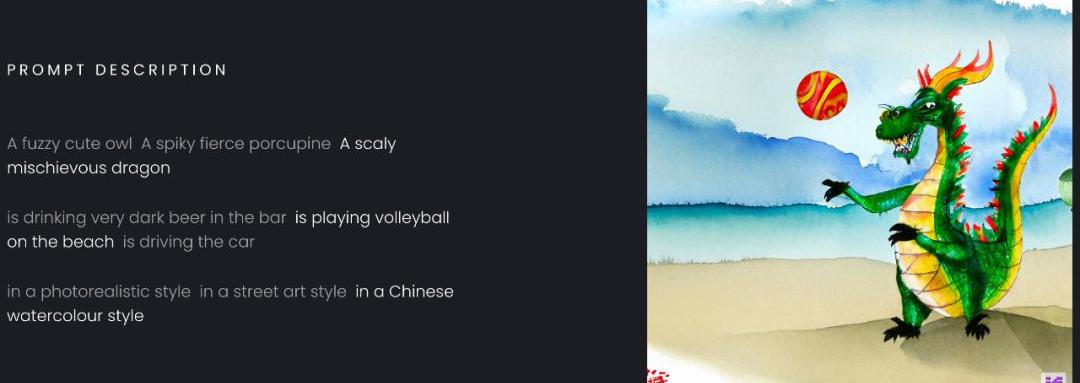

除此之外,DeepFloydIF还能够生成正确的空间关系。

模型刚一发布,网友们已经玩疯了:

prompt:Robotholdinganeonsignthatsays"Icanspell".

比特币投资人推特账号“alistairmilne”贴出18000个BTC的转移记录,疑似门头沟托管方过去6个月的抛售前操作:继门头沟托管方透露过去6个月出售了3.6亿美元BTC和4400万美元BCH,称2月6日它的币值曾一度跌到6千美元的暴跌是他的抛售导致的,今日比特币投资人推特账号“alistairmilne”今日贴出了2月6日的超大额18000个BTC的转移记录。[2018/3/8]

不过,对于prompt中没有明确说明的文字,DeepFloydIF大概率还是会出错。

prompt:AneonsignofanAmericanmotelatnightwiththesignjavilop

官方演示

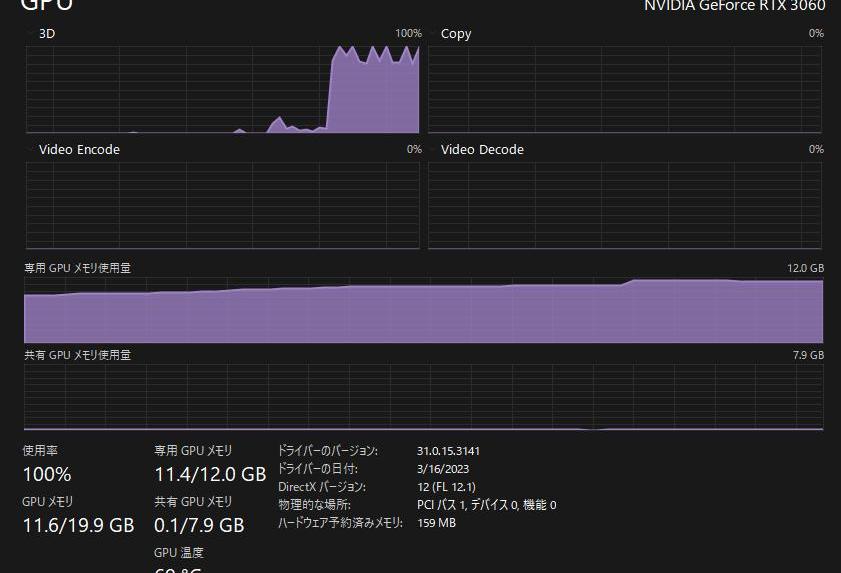

顺便一提,在硬件的需求上,如果想要实现模型所能支持的最大1,024x1,024像素输出,建议使用24GB的显存;如果只要256x256像素,16GB的显存即可。

是的,RTX306016G就能跑。

代码实现:https://gist.github.com/Stella2211/ab17625d63aa03e38d82ddc8c1aae151

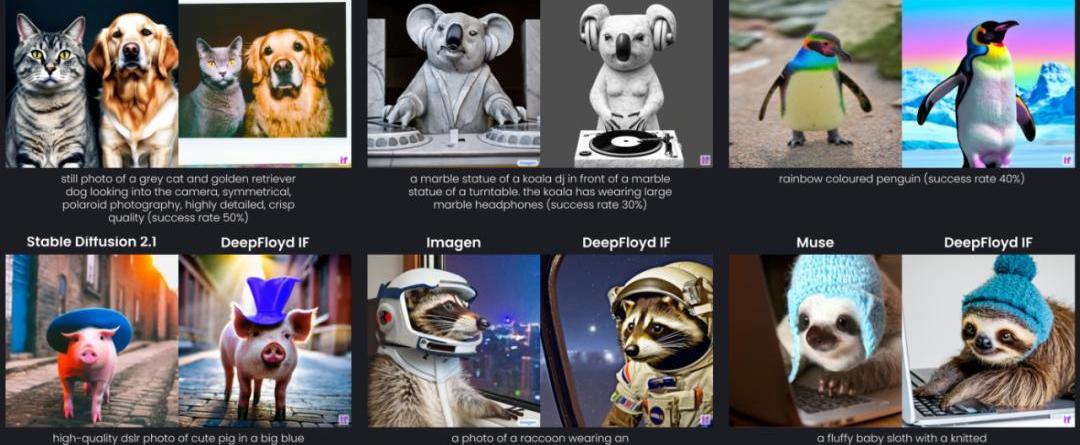

开源版谷歌Imagen

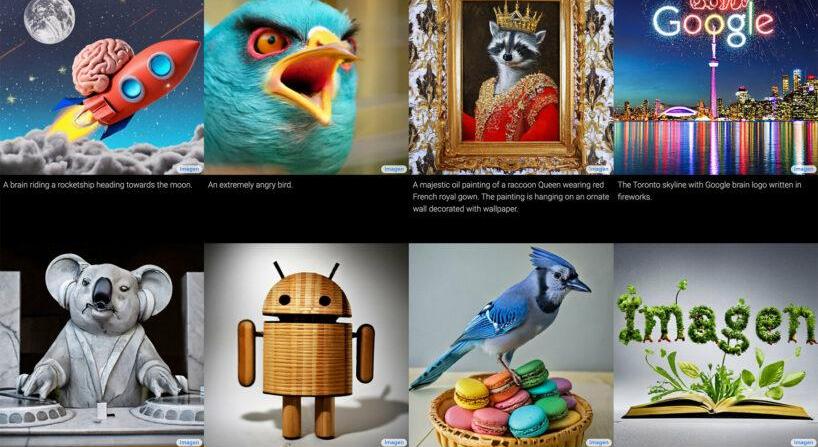

2022年5月,谷歌高调发布了自家的图像生成模型Imagen。

根据官方演示的效果,Imagen不仅在质量上完胜OpenAI最强的DALL-E2,更重要的是——它能够正确地生成文本。

迄今为止,没有任何一个开源模型能够稳定地实现这一功能。

与其他生成式AI模型一样,Imagen也依赖于一个冻结的文本编码器:先将文本提示转换为嵌入,然后由扩散模型解码成图像。但不同的是,Imagen并没有使用多模态训练的CLIP,而是使用了大型T5-XXL语言模型。

这次,StabilityAI推出的DeepFloydIF复刻的正是这一架构。

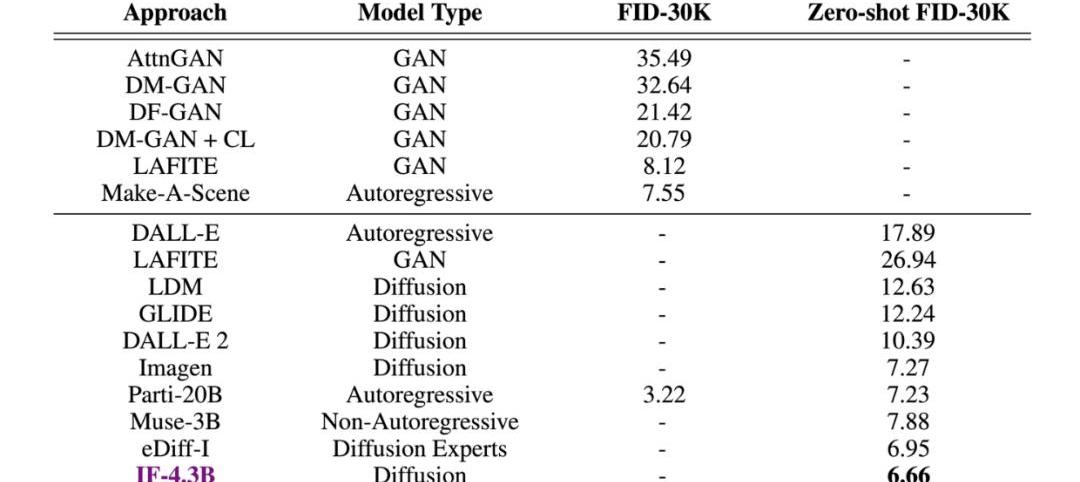

甚至在测试中,DeepFloydIF凭借着COCO数据集上6.66的zero-shotFID分数,直接超越了谷歌的Imagen,以及一众竞品。

下一代图像生成AI模型

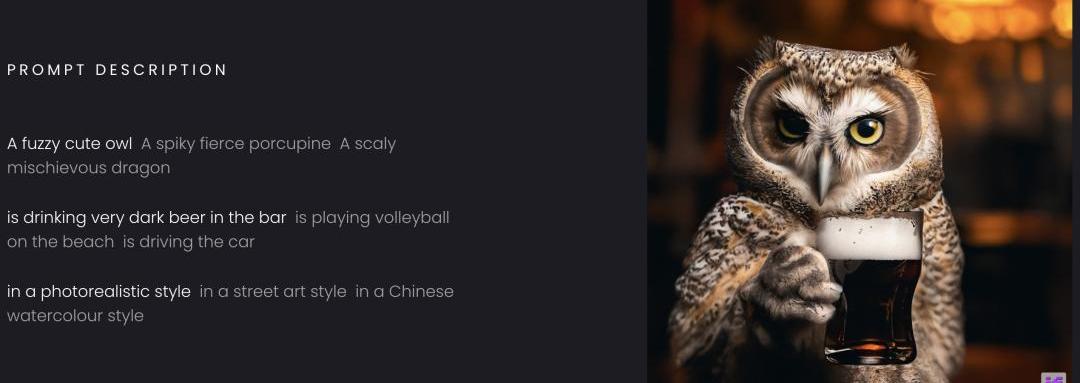

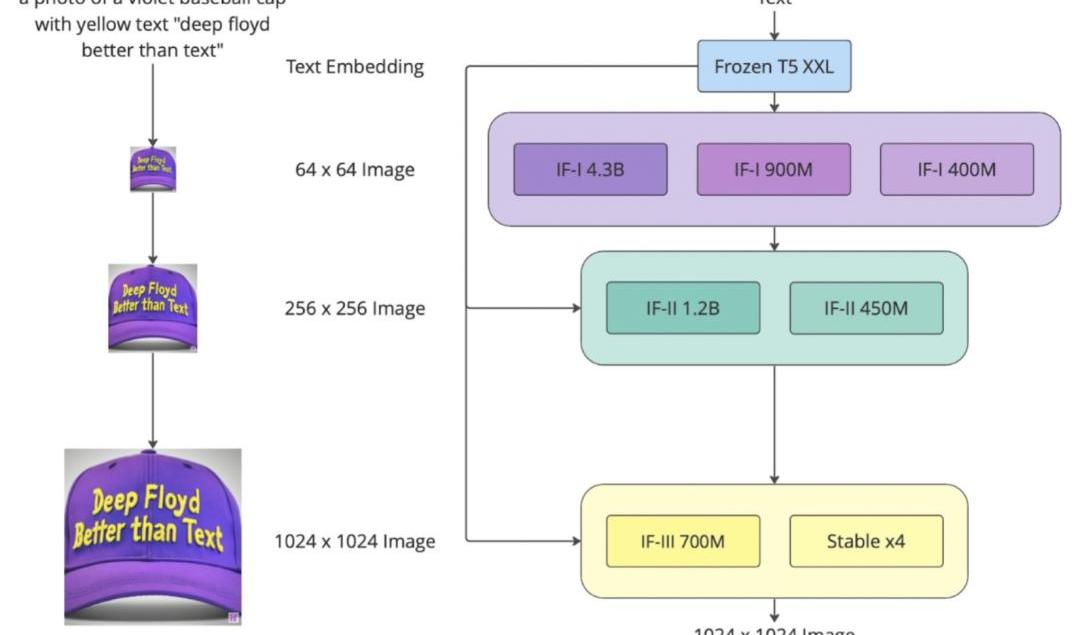

具体来说,DeepFloydIF是一个模块化、级联的像素扩散模型。

模块化:

DeepFloydIF由几个神经模块组成,它们在一个架构中相互协同工作。

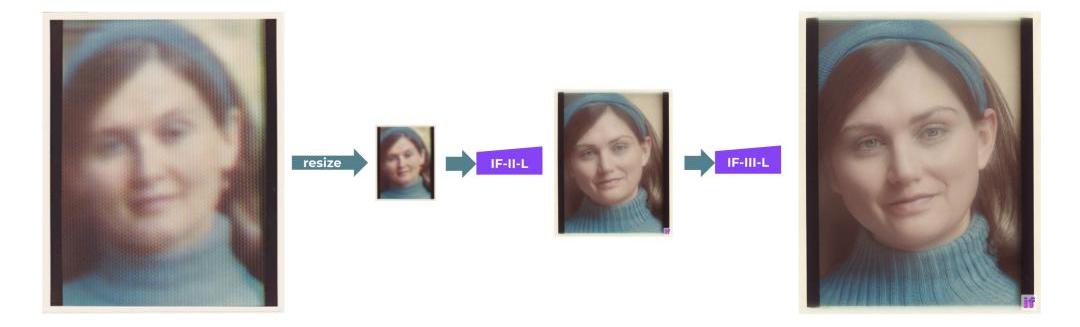

级联:

DeepFloydIF以多个模型级联的方式实现高分辨率输出:首先生成一个低分辨率的样本,然后通过连续的超分辨率模型进行上采样,最终得到高分辨率图像。

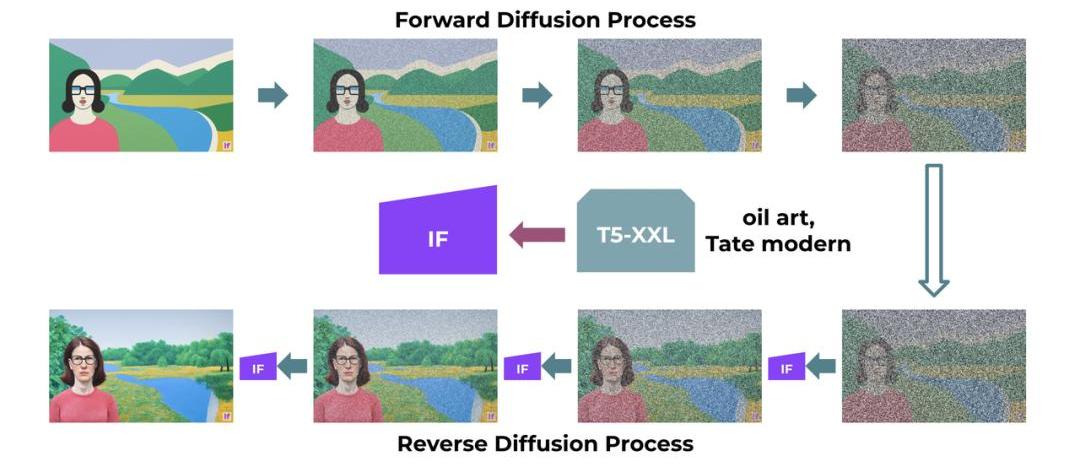

扩散:

DeepFloydIF的基本模型和超分辨率模型都是扩散模型,其中使用马尔可夫链的步骤将随机噪声注入到数据中,然后反转该过程从噪声中生成新的数据样本。

像素:

DeepFloydIF在像素空间工作。与潜在扩散模型不同,扩散是在像素级别实现的,其中使用潜在表征。

上面这个流程图展示的就是,DeepFloydIF三个阶段的性能:

阶段1:

基本扩散模型将定性文本转换为64x64图像。DeepFloyd团队已经训练了三个版本的基本模型,每个版本都有不同的参数:IF-I400M、IF-I900M和IF-I4.3B。

阶段2:

为了「放大」图像,团队将两个文本条件超分辨率模型应用于基本模型的输出。其中之一将64x64图像放大到256x256图像。同样,这个模型也有几个版本:IF-II400M和IF-II1.2B。

阶段3:

应用第二个超分辨率扩散模型,生成生动的1024x1024图像。最后的第三阶段模型IF-III拥有700M参数。

值得注意的是,团队还没有正式发布第三阶段的模型,但DeepFloydIF的模块化特性让我们可以使用其他上采样模型——如StableDiffusionx4Upscaler。

团队表示,这项工作展示了更大的UNet架构在级联扩散模型的第一阶段的潜力,从而为文本到图像合成展示了充满希望的未来。

数据集训练

DeepFloydIF是在一个定制的高质量LAION-A数据集上进行训练的,该数据集包含10亿对。

LAION-A是LAION-5B数据集英文部分的一个子集,基于相似度哈希去重后获得,对原始数据集进行了额外的清理和修改。DeepFloyd的定制过滤器用于删除水印、NSFW和其他不适当的内容。

目前,DeepFloydIF模型的许可仅限于非商业目的的研究,在完成反馈的收集之后,DeepFloyd和StabilityAI团队将发布一个完全免费的商业版本。

参考资料:

https://stability.ai/blog/stablevicuna-open-source-rlhf-chatbot

https://stability.ai/blog/deepfloyd-if-text-to-image-model

以太坊的质押从2020年11月开始,直至最近的上海升级才开通赎回功能,随着质押率的上升,质押收益率也在不断下降。截至4月26日,OKLink显示,当前整体质押率为14.54%,质押的年化收益率为3.92%.

1900/1/1 0:00:00撰文:孟铉济,FoxTech首席科学家;康水跃,FoxTechCEO 前言 Layer1作为一种分布式系统,为了达成共识需要高昂的通讯代价,并且大量的计算也会消耗昂贵的gas.

1900/1/1 0:00:00金色财经报道,以太坊联合创始人VitalikButerin在Zuzalu核心开发演示期间宣布ETH3.0路线图。以太坊3.0路线图承诺对网络进行重大升级和更改,包括引入权益证明共识机制、分片等.

1900/1/1 0:00:00来源:澎湃新闻 记者方晓 图片来源:由无界AI工具生成·欧盟拟要求开发ChatGPT等生成式人工智能工具的公司披露是否在系统中使用了受版权保护的材料。该协议为世界上第一部综合性人工智能法律《人工智能法》铺平道路,预计将产生全球性影响.

1900/1/1 0:00:00本文来自Coingecko,原文作者:LimYuQian,由Odaily星球日报译者Katie辜编译.

1900/1/1 0:00:00文: 娱乐独角兽,作者:赤木瓶子,编辑:把青由AI创作的第一首“神曲”走红不到一个月,便被唱片公司与流媒体联合抵制下架,这并不是“赛博战役”的首次打响.

1900/1/1 0:00:00