来源:新智元编辑:Aeneas好困

快速定制模型的LLM引擎Lamini来了,开发者狂喜!

ChatGPT虽好,但始终有门槛。通常,只有拥有AI博士学位的大型机器学习团队,才能这样训练一个模型。

为了把这个门槛打下来,团队构建了Lamini引擎,从此,每个开发者都能够拥有从GPT-3训练ChatGPT的超能力!

划重点:可以商用!可以商用!可以商用!

项目地址:https://github.com/lamini-ai/lamini/

Lamini的开发团队表示,你需要的只是几行代码,就可以用托管数据生成器俩训练自己的LLM,包括权重和其他所有的内容。

此外,你也可以使用开源的LLM,用Lamini库对生成的数据进行微调。以及访问完整的LLM训练模块,使用从LoRa等速度优化,到虚拟私有云(VPC)部署等企业功能。

对此,英伟达科学家JimFan表示,LLaMa+自定义数据正在成为新的范式,而Lamini的推出也带了一种全新的模式——FaaS,微调即服务。

Do Kwon拒绝在黑山法庭保释听证会上批露其资产确切数额:5月12日消息, Terraform Labs 联合创始人 Do Kwon 被怀疑在涉嫌加密货币证券欺诈后藏匿了大量资产,他在黑山法庭的审判中拒绝透露其资产的确切数额。在周四对伪造护照的指控进行审判时,Do Kwon 要求以 40 万欧元(约 5.8 亿韩元)的保释金保释,但随后被法官问及他打算如何支付保释金。Do Kwon 表示,他的妻子会支付这笔款项,他在韩国拥有一套公寓。但当法官询问他时,他拒绝在媒体面前提供自己的资产细节。法官称若不进一步披露资产,就无法做出保释决定时,Do Kwon 表示,他与妻子共同拥有的公寓单元价值约 300 万美元。[2023/5/12 14:59:31]

MLOps的未来是「LMOps」。哪里有标准化,哪里就有机会。

OpenAI科学家,前特斯拉人工智能总监AndrejKarpathy也表示,LLM定制化的生态正在愈发火爆。

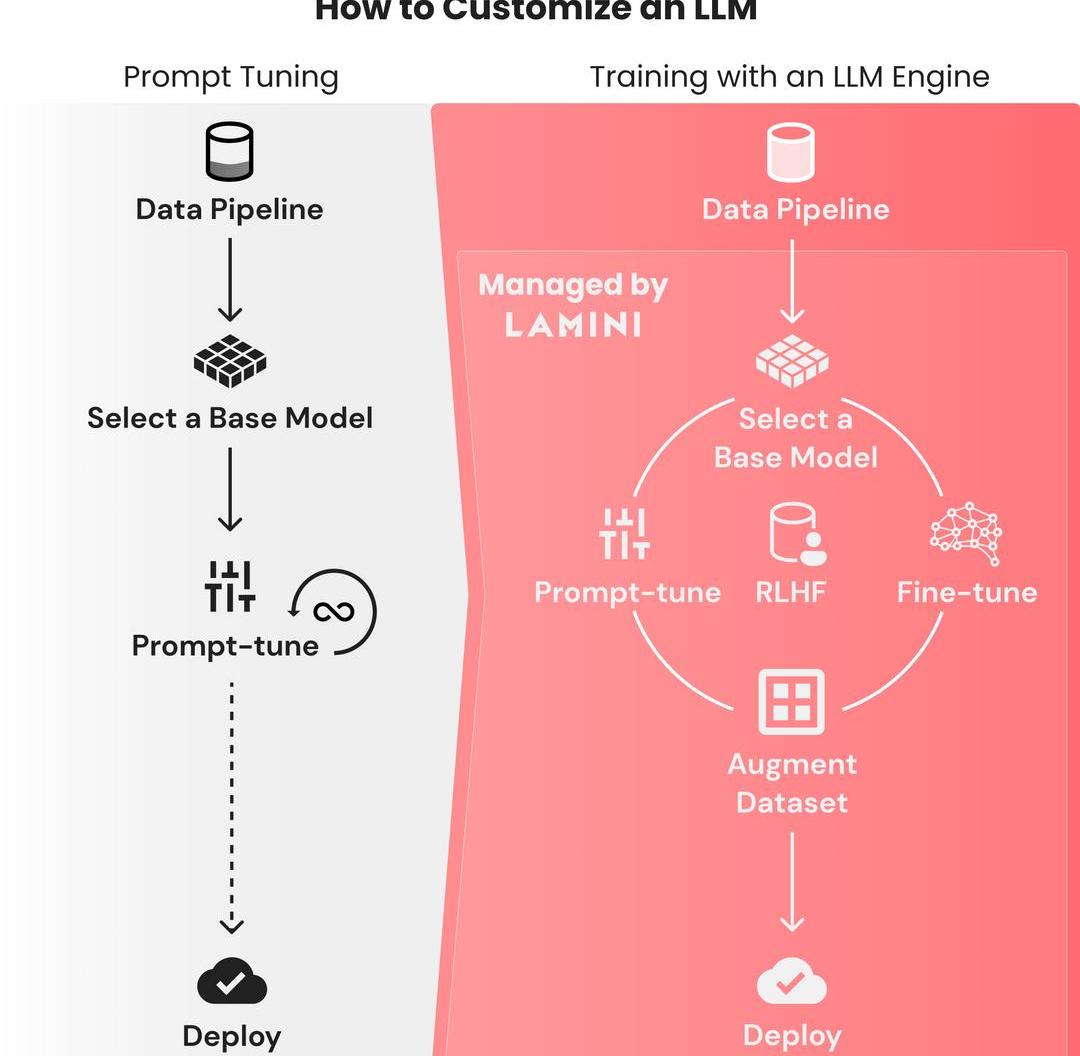

训LLM就像prompt-tuning一样简单

写一个prompt如此容易,但想要从基础模型训练出一个大语言模型,却是如此困难。

因为需要花费大量时间,来找出微调模型失败的原因,所以对数据集微调的迭代周期都是以月为单位的。

与之相反,微调prompt的迭代,只需要几秒钟,并且在几个小时内,性能都能保持稳定。

这个过程只需要把有限数量的数据整合到prompt中就可以了,并不需要动辄几TB的数据。

Fluree完成1000万美元A轮融资,SineWave Ventures领投:4月20日消息,Web3数据管理工具开发公司Fluree宣布完成1000万美元A轮融资,SineWave Ventures领投,截至目前该公司的融资总金额已超过1600万美元。

据悉,Fluree主要提供区块链支持的语义图形数据库,帮助企业管理数据资产,通过结合许可区块链技术、语义Web标准和数据安全策略控制,让开发人员以去中心化和可信的格式存储和管理数据。 (venturebeat)[2023/4/20 14:15:15]

ChatGPT的诞生十分艰难,OpenAI的团队花了几个月的时间,在基础的GPT-3模型上微调,并进行RLHF。这个门槛极高,只有大型的ML团队才能完成这种训练。

有500强企业的技术负责人这样抱怨过:「我们团队的10名机器学习工程师用了OpenAI的微调API,结果我们的模型反而变得更差了,怎么办啊。」

「我真的不知道该怎么充分利用数据,我已经用尽了所有从在线教程中能学到的prompt魔法了。」

这,就是研究者构建Lamini的原因:让每个开发者可以直接从GPT-3训练ChatGPT。

任意LLM,秒变ChatGPT!

Lamini是一个LLM引擎,可以让不仅仅是机器学习专家的任何开发人员,都能在大型数据集中,把高性能的LLM训练得像ChatGPT一样好。

这个过程,只需要Laimini库的几行代码即可。

值得注意的是,这个库中的优化远远超出了现在开发者可以使用的范围,从更具挑战性的优化到更简单的优化。

比如,你想从不同的角度生成一个广告文案。

首先,从llama模块导入LLM引擎:

fromllamaimportLLMllm=LLM(name="marketing")

Silvergate Bank存款缩水前仅11%的流动性资产为现金:金色财经报道,加密友好银行SilvergateBank将大部分新资金投入了较长期的债券中,在去年第三季度末其存款开始迅速缩水之前,仅有11%的流动性资产是储存在美国联邦储备银行和其他银行的现金,其余部分是证券。而这些证券中仅有11%是美国国债,其余大部分是具有10年以上合同到期期限的抵押贷款支持债券,因此在其开始抛售这些证券以满足提款需求之前,其债券持仓已经遭受了10亿美元的公允价值损失。[2023/3/6 12:45:06]

接下来,需要定义输入和输出类型。注意,这里一定要包括上下文,因为可以有助于LLM在自然语言中进行理解。

fromllamaimportType,ContextclassAdAspects(Type):tone:str=Context("toneofthemarketingcopy")product_features:list=Context("productfeaturestopromote")audience:str=Context("targetaudienceforthemessage")subject:str=Context("subjectortopicofthemessage")goal:str=Context("goalofthismarketingcampaignandmessage")classAdCopy(Type):title:str=Context("googleadtitletag")description:str=Context("googleaddescription")keywords:list=Context("keywordsforthesearchengine")

然后就可以开始提问了:

语气:大胆,但不傲慢

特色:亚洲酱料和香料、家常调料和套餐包,可以轻松在家烹饪。

OpenSea Seaport V1.2合约现已部署至多个EVM链:金色财经报道,OpenSea协议开发负责人0age发推表示,Seaport V1.2合约现已部署至多个EVM链中,包括新增批量上架、合约可插入Seaport与标准上线互操作、更节省Gas等功能或特点,其中批量上架允许用户在一个签名中创建多达1600万个不同的上架。之前的Seaport V1.1合约仍然可用。[2023/2/3 11:45:01]

aspects=AdAspects(tone="boldandbright,butnotarrogant",product_features=,audience="suburbanfamilies",subject="deliciousasianmealswithoutgoingtoarestaurant",goal="getsuburbanmomsanddadstotrybuytheirfirstomsompackorfreetastingkit")ad_copy=llm(input=aspects,output_type=AdCopy)print(f"Adcopy:{ad_copy}")模型输出:

尝试Omsom的美味亚洲酱料、香料、家常调料和套餐包。轻松为家人在家做出美味佳肴。

>title='DeliciousAsianMealsWithoutGoingtoaRestaurant|Omsom'description="TryOmsom'sdeliciousAsiansauces,aromatics,andhome-cookedseasoningsandmealpacks.Easilycookdeliciousmealsathomeforyourfamily."keywords=

如何创建自己的「ChatGPT」

基础模型能理解一般的英语,但如果需要它们学习一些垂直语言和规则,prompt微调并不足够,很多时候我们都需要构建自己的LLM。

马斯克:如果佛罗里达州共和党州长Ron DeSantis在2024年竞选总统将支持他:金色财经报道,马斯克周五表示,如果佛罗里达州共和党州长Ron DeSantis在2024年竞选总统,将支持他。据悉,Ron DeSantis是Donald Trump的竞争对手,很可能会在共和党初选中与他对决。马斯克此前暗示没有在民主党人中找到理想的候选人。[2022/11/27 20:55:23]

利用用下面这个步骤,就能获得像ChatGPT一样遵循指令的LLM。

尝试prompt-tuningChatGPT或其他模型

可以使用Lamini库的API,在不同模型之间快速进行prompt-tuning,只需一行代码,即可在OpenAI和开源模型之间切换。

Lamini库已经优化了正确的prompt,这样开发者就可以使用不同的模型,不必担心如何为每个模型设置prompt的格式。

构建一个包含输入-输出对的大型数据集

这些数据集会向模型展示,它应该如何响应输入,无论是遵循英文说明,还是以JSON响应。

研究者刚刚发布了一个只有几行代码的repo,使用Lamini库,仅从100个数据点中,就能生成50k数据点。

而且因为使用Lamini库来启动Lamini引擎,所以这个过程根本不需要用到GPU。

在repo中,已经包含一个开源的70+k数据集。

项目地址:https://github.com/lamini-ai/lamini/

在大型数据集上微调基础模型

除了数据生成器,研究者还发布了一个LLM,它使用Lamini对生成的数据进行了微调。以编程方式执行此操作的功能也会很快发布。

也可以把OpenAI的微调API作为起步。

在微调模型上进行RLHF

使用Lamini,就不再需要大型ML和人工标记团队来运行RLHF。

部署到云端

只需点击产品或功能中的API端点即可。

专为LLM打造的数据生成器

简单来说,依照以下几个步骤,就可以训练自己的大语言模型了。

用于优化prompt微调和类型化输出的Lamini库。

用于微调和RLHF的高级Lamini库,只需几行代码。

史上首个托管数据生成器,用于创建数据,来训练遵循指令的LLM。注意,已获得商业使用许可!

开源的指令跟随LLM,使用上述工具,只需几行代码即可完成。

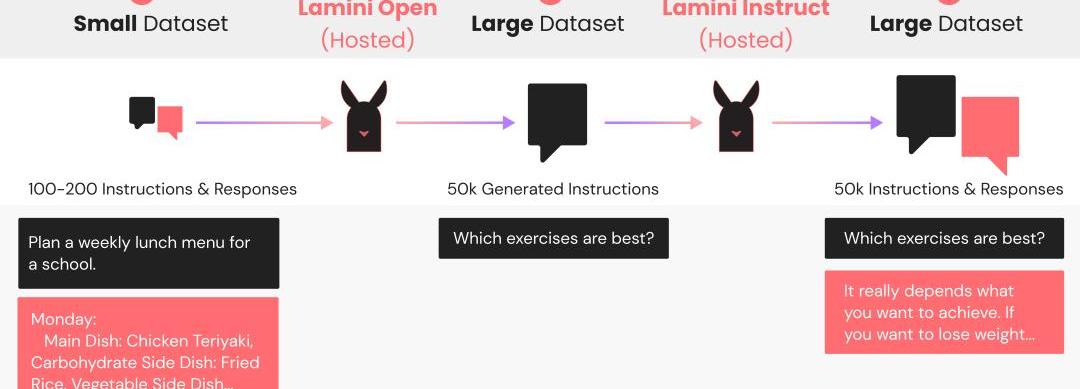

数据生成器工作原理

Lamini数据生成器是一个LLM管线,它采用原始的100多条指令的小集合,与预期的响应配对,生成50k+新的配对,灵感来自Stanford的Alpaca。这个生成管线使用Lamini库来定义和调用LLM,以生成不同但相似的指令和响应对。

根据这些数据训练后,你的LLM会遵循这些指示,因而得到改进。对于使用开源LLM的生成管线,研究者提供了一个很好的默认值,LaminiOpen和LaminiInstruct。

随着每天新的LLM发布,研究者都会将默认值更新为性能最佳的模型。在目前的版本中,LaminiOpen用的是EleutherAI的Pythia,LaminiInstruct用的是Databricks的Dolly。

LaminiOpen会生成更多指令,而LaminiInstruct会生成这些指令的成对响应。

最终生成的数据集可供免费商业使用,已经通过CC-BY许可。

仅用一行代码,就可以将Lamini库的默认值换成其他开源或OpenAI模型。

研究者发现,OpenAI模型的平均表现更好,但它们的许可限制了将生成数据用于训练类ChatGPT模型的商用。

对生成数据进行微调

在这个过程中,生成的数据会质量不一。

在微调之前,下一步就是将生成的数据过滤为高质量数据。

然后,Lamini会通过在这个过滤后生成的数据集上训练基础模型,来创建自定义LLM。

研究者已经发布了一个开源指令跟随LLM,可以用Lamini来训练Pythia基础模型,生成的37k指令是从70k中筛选出来的。

显然,Lamini库的出现,让迭代周期变得更快、更有效,有更多的人能够构建模型,而不仅仅是试验各种prompt。

团队介绍

SharonZhou是Lamini的联合创始人兼首席执行官。

个人主页:https://sharonzhou.me/

她在哈佛大学获得了计算机科学与古典文学联合学士学位,并以最高荣誉获得了硕士学位。

随后,她在斯坦福大学获得了计算机科学博士学位,师从吴恩达。

2022年,29岁的Zhou入选《麻省理工科技评论》「35岁以下科技创新35人」。

GregoryDiamos是MLPerf的联合创始人。

他曾是百度硅谷AI实验室的创始成员,对DeepSpeech和DeepVoice系统有贡献。

参考资料:

https://lamini.ai/blog/introducing-lamini

标签:MINMINIROMPROOceans Minergemini女朋友微博IDROMEODOGE币YFPRO Finance

原文作者:/img/20230515155638404902/0.jpg "/>Meme完成500万美元融资,DFG参投:5月27日消息,专注于meme和NFT的新市场Meme.com获500万美元融资.

1900/1/1 0:00:002023年五一劳动节当日,Blur联合Paradigm推出点对点NFT借贷协议Blend。最新数据显示,Blend已贷出18,528枚ETH,撮合成交1405笔借贷。 Paradigm也于5月1日发文深度解读了Blend协议.

1900/1/1 0:00:00原文作者:0xmin 原文来源:TechFlow深潮 “醋不及防”,PEPE神话又开始让众人开始因别人家的发财故事而感到焦虑.

1900/1/1 0:00:00头条 BNBGreenfield?主网将于今年第三季度启动Odaily星球日报讯去中心化存储基础设施BNBGreenfield主网将于?2023?年第三季度启动.

1900/1/1 0:00:00作者:举大名耳,来源:?阿尔法工场研究院导语:面对苹果今天在AI上的种种困境,人们不禁在想,倘若面对这些难题的是乔布斯,他又会如何决断呢?在今年爆发的AI大战中,微软、谷歌、亚马逊等各个大厂,都纷纷使出了自己的浑身解数.

1900/1/1 0:00:00引言 硅谷银行挤兑事件后的危机决策,使人们对银行业作为公私合营的地位产生了怀疑,因为政府现在隐含地对私人信贷资金提供了无限的公共支持。这是解决与货币和信贷之间关系有关的古老问题的一个尴尬的方式.

1900/1/1 0:00:00