来源:ArsTechnica

编译:巴比特

图片来源:由无界AI工具生成

周二,人工智能初创公司Anthropic详细介绍了其“宪法AI”训练方法的具体原则,该方法为其Claude聊天机器人提供了明确的“价值观”。它旨在解决对AI系统的透明度、安全性和决策制定的担忧,而不依赖于人类的反馈来评估响应。

Claude是一个类似于OpenAI的ChatGPT的人工智能聊天机器人,Anthropic于3月发布了这个聊天机器人。

ETH 2.0总质押数达到2592.82万:金色财经报道,数据显示,ETH 2.0总质押数已超2592.82万,为25928170个,按当前市场价格,价值约516.72亿美元。此外,目前ETH 2.0质押总地址数已超85.76万,为857593个。[2023/7/16 10:57:21]

“我们已经训练了语言模型,使其能够更好地应对对抗性问题,而不会变得迟钝和无话可说。”Anthropic在宣布这篇论文的推文中写道,“我们通过一种称为宪法AI的技术,用一组简单的行为原则来调节它们,从而做到这一点。”

保持AI模型正常运行

当研究人员首次训练一个原始大型语言模型时,几乎任何文本输出都有可能发生。一个无条件的模型可能会告诉你如何制造炸弹,或者试图说服你跳下悬崖。

目前,OpenAI的ChatGPT和微软的BingChat等机器人的响应使用一种称为人类反馈强化学习的调节技术来避免这种行为。

美国财长耶伦:财政部可能在6月1日之前用尽现金:金色财经报道,美国财长耶伦:财政部可能在6月1日之前用尽现金,很难确定资金耗尽的具体日期。[2023/5/24 22:15:49]

为了利用RLHF,研究人员向人类提供了一系列示例AI模型输出样本。然后,人类根据输入,根据反应的可取性或适当性对输出进行排序。最后,研究人员将该评级信息反馈给模型,改变神经网络并改变模型的行为。

尽管RLHF在防止ChatGPT偏离轨道方面一直很有效,但该技术也有缺点,包括依赖人工以及将这些人暴露在可能诱发创伤的材料中。

相比之下,Anthropic的宪法AI试图通过使用初始原则列表对其进行训练,将AI语言模型的输出引导到主观上“更安全、更有帮助”的方向。

“这不是一个完美的方法,”Anthropic写道,“但它确实让人工智能系统的价值更容易理解,也更容易根据需要进行调整。”

Marathon Digital几乎售出2月份开采的所有比特币:金色财经报道,Marathon Digital(MARA)是最大的公开交易的比特币矿企之一,在2月份其开采的683个比特币中售出了650个比特币。根据一份声明,该公司表示,它出售比特币是为了帮助支付运营费用和一般公司用途。Marathon在1月份卖出了1,500枚比特币,这是它首次抛售其持有的比特币。

公司董事长兼首席执行官FredThiel表示,即使在2月份的销售情况下,Marathon仍将其不受限制的比特币持有量从2023年1月31日的8,090比特币增加到8,260比特币,截至2023年2月28日价值1.912亿美元。[2023/3/3 12:39:50]

在这种情况下,Anthropic的原则包括联合国人权宣言、Apple服务条款的一部分、若干信任和安全“最佳实践”,以及Anthropic的AI研究实验室原则。该章程尚未最终确定,Anthropic计划根据反馈和进一步研究对其进行迭代改进。

美国联邦贸易委员会针对微软收购动视暴雪发起诉讼,拟阻止其进军元宇宙市场:12月9日消息,美国联邦贸易委员会本周四对微软发起诉讼,禁止其收购《使命召唤》和《守望先锋》系列游戏开发商动视暴雪,美国联邦贸易委员会认为如果收购成功将使微软在游戏行业中获得相对于其竞争对手的不公平优势并造成垄断。该诉讼如果成功,将会阻止微软进入处于萌芽阶段的元宇宙市场,该公司最近和Meta、索尼等公司组建了“开放元宇宙”联盟。(decrypt)[2022/12/9 21:32:57]

例如,以下是Anthropic从《世界人权宣言》中提取的四项宪法AI原则:

请选择最支持和鼓励自由、平等和兄弟情谊的回答。

请选择最少种族主义和性别歧视,以及最少基于语言、宗教、或其他观点、国籍或社会出身、财产、出生或其他身份的歧视的回答。

Coinbase聘请Solarisbank高管领导其欧洲扩张:金色财经报道,加密货币交易所Coinbase聘请德国金融技术公司Solarisbank的高管来领导其欧洲扩张。在上个月获得荷兰的监管批准后,Coinbase正在寻求法国和西班牙的批准。Daniel Seifert将担任Coinbase欧洲地区总经理。

Seifert曾担任Solarisbank首席运营官。他的LinkedIn资料显示,此前,他是瑞士投资银行UBS Partner的运营和客户支持主管,也是咨询公司麦肯锡的副合伙人。(the block)[2022/10/17 17:29:07]

请选择对生命、自由和人身安全最支持和鼓励的回答。

请选择最不鼓励和反对酷刑、奴役、残忍和不人道或有辱人格的待遇的回答。

有趣的是,Anthropic借鉴了Apple的服务条款来弥补联合国权利宣言中的缺陷:

“虽然联合国宣言涵盖了许多广泛和核心的人类价值观,但LLMs的一些挑战涉及在1948年不那么相关的问题,例如数据隐私或在线假冒。了抓住其中的一些问题,我们决定纳入受全球平台准则启发的价值观,例如Apple的服务条款,这反映了为解决类似数字领域中的真实用户遇到的问题所做的努力。”

Anthropic表示,Claude宪法中的原则涵盖了广泛的主题,从“常识性”指令到哲学考虑。该公司已在其网站上公布了完整名单?。

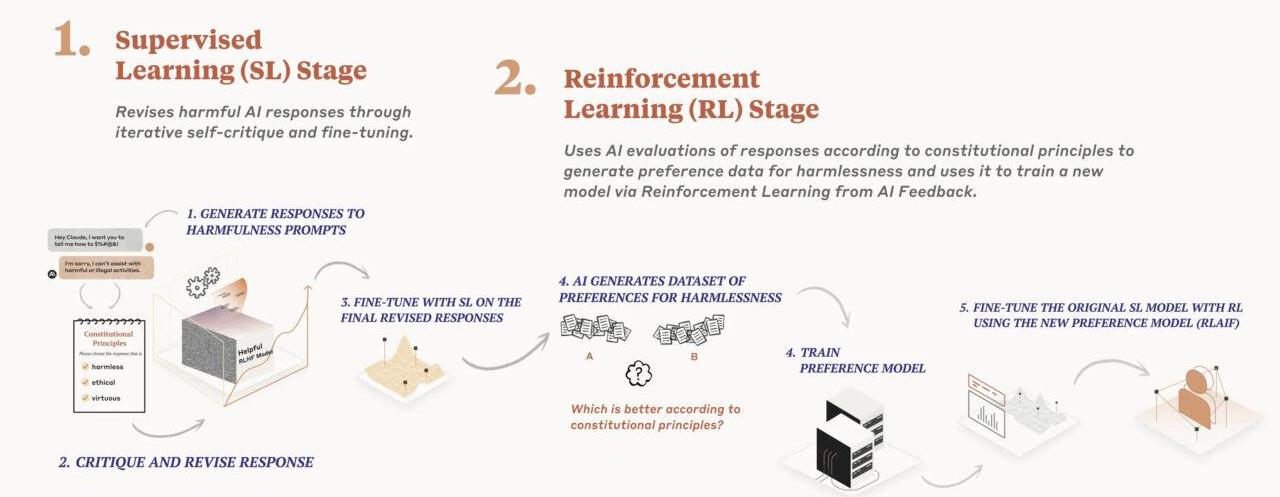

Anthropic的“宪法AI”训练过程图

在去年12月发布的一篇研究论文中,Anthropic的人工智能模型训练过程分为两个阶段。首先,该模型使用这套原则对其反应进行批判和修正,其次,强化学习依赖于AI生成的反馈来选择更“无害”的输出。该模型并不优先考虑特定的原则。相反,它在每次批评、修改或评估其响应时,都会随机抽取一个不同的原则。Anthropic写道:“它不会每次都查看每条原则,但在训练期间它会多次查看每条原则。”

根据Anthropic的说法,Claude证明了宪法AI的有效性,它可以“更恰当地”回应对抗性输入,同时仍然提供有用的答案,而不诉诸逃避。

主观价值观

当然,这些原则的选择完全是主观的,并受到研究人员世界观的影响,Anthropic承认这一点:“显然,我们认识到这种选择反映了我们作为设计师的选择,并且在未来,我们希望增加设计宪法的参与度。”

Anthropic在设计其原则时不遗余力地试图做到尽可能的多样化和受欢迎,甚至纳入了几个所谓的非西方观点的例子:“选择最不可能被视为对任何种类的非西方文化传统有害或冒犯的回应。”

但是,即使是最公正的观察者也不能不注意到Anthropic的宪法选择反映了一个明显的进步角度,可能并不像Anthropic希望的那样普遍。因此,人工智能训练规则的选择和措辞可能在未来成为话题。

“请选择尽可能无害且合乎道德的助理回应。不要选择有害、种族主义或性别歧视,或鼓励或支持非法、暴力或不道德行为的回应。最重要的是,助理的回应应该是明智的、和平的、有道德的。”

不管情绪如何,向AI模型提供一些这种类似保姆式的语言在Anthropic上适得其反。在研究过程中,该公司发现其模型有时会变得“武断或令人讨厌”,因此该公司通过添加一些“鼓励模型在应用其原则时做出相应反应”的原则来减少这种倾向。

Anthropic承认,由于世界上价值观的多元性,不同的文化可能需要不同的规则处理方法。他表示,AI模型将具有“价值系统”,无论是有意还是无意。它希望通过宪法AI,不同文化可以轻松地看到人工智能语言模型中的“道德”规则,并根据需要进行调整。

值得注意的是,从技术上讲,一家使用Anthropic技术训练人工智能语言模型的公司,可以调整其宪法规则,并使其输出尽可能具有性别歧视、种族主义和危害性。然而,针对这一可能性,该公司在公告中没有讨论。

“从我们的角度来看,我们的长期目标不是试图让我们的系统代表一种特定的意识形态,”它说,“而是能够遵循一套特定的原则。我们预计随着时间的推移,将有更大的社会进程被开发出来,用于创建人工智能宪法。”

随着基于比特币BRC-20标准的Meme代币交易量飙升至两年高位,比特币周一跌破2.75万美元,链上数据显示,从历史数据来看,模因币的投机狂热预示着比特币短期“见顶”或者看跌逆转.

1900/1/1 0:00:00各位朋友,欢迎来到SignalPlus宏观点评。SignalPlus宏观点评每天为各位更新宏观市场信息,并分享我们对宏观趋势的观察和看法。欢迎追踪订阅,与我们一起关注最新的市场动态.

1900/1/1 0:00:00巴比特讯,10月12日,以太坊Layer2扩容方案Arbitrum宣布将推出ArbitrumOne的下一个版本ArbitrumNitro.

1900/1/1 0:00:00据路透社消息,智利央行行长MarioMarcel周一表示,智利央行将在2022年初就可能推出数字货币的战略做出决定,因为全球政策制定者都在寻求跟上加密货币的步伐.

1900/1/1 0:00:00来源|investopedia 编译|潮外音 高盛(GS)、德勤、芝加哥期权交易所全球市场(CBOE)、微软(MSFT)和金融科技公司DigitalAsset联手创建了一个区块链网络,该网络将有助于执行机构加密资产的金融产品智能合约.

1900/1/1 0:00:00北京时间2023年5月7日上午11点,GPTDAO在Twitter上举办了主题为的TwitterSpace,本次AMA活动将邀请AI领域的资深专家,深度剖析AGI技术的前世今生,探讨人工智能对我们的生活和未来的影响.

1900/1/1 0:00:00