编辑:LRS

注意力机制这么好用,怎么不把它塞到卷积网络里?最近MetaAI的研究人员提出了一个基于注意力的池化层,仅仅把平均池化层替换掉,就能获得+0.3%的性能提升!

VisualTransformer作为计算机视觉领域的新兴霸主,已经在各个研究任务中逐渐替换掉了卷积神经网络CNN。

ViT与CNN之间存在着许多不同点,例如ViT的输入是imagepatch,而非像素;分类任务中,ViT是通过对类标记进行决策等等。

classtoken实际上是ViT论文原作者提出,用于整合模型输入信息的token。classtoken与每个patch进行信息交互后,模型就能了解到具体的分类信息。

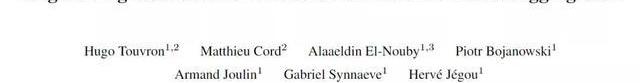

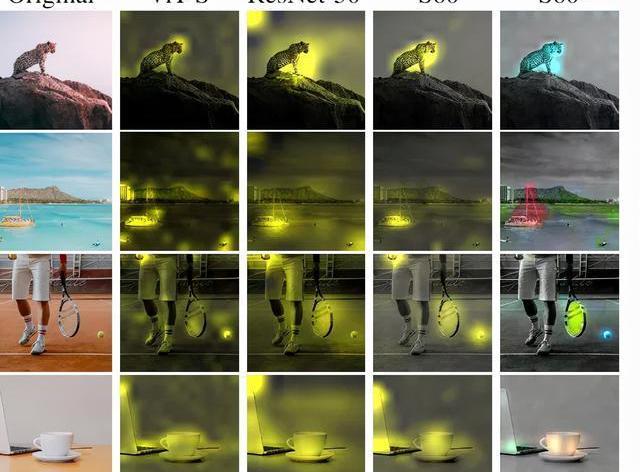

并且在自注意力机制中,最后一层中的softmax可以作为注意力图,根据classtoken和不同patch之间的交互程度,就能够了解哪些patch对最终分类结果有影响及具体程度,也增加了模型可解释性。

但这种可解释性目前仍然是很弱的,因为patch和最后一层的softmax之间还隔着很多层和很多个header,信息之间的不断融合后,很难搞清楚最后一层softmax是否真的可以解释分类。

MakerDAO声明:无法控制Oasis,Jump反向攻击黑客不涉及其智能合约:2月25日消息,因Jump Crypto与Oasis联合通过逆向攻击追回12万枚ETH的Wormhole被盗资金,MakerDAO发推特声明,鉴于最近有关 Maker Vault 30100和Oasis前端的交易,需要解释 MakerDAO、Maker 协议和第三方前端提供商之间的区别。MakerDAO 无法控制任何使终端用户能够访问 Maker Vaults 的前端提供商或产品。

此外,连接到 Maker 协议的可用前端都不是由 MakerDAO 开发或维护的Maker 协议是一个去中心化的智能合约系统,公开部署在以太坊上,允许任何供应商以无许可和去中心化的方式连接其用户界面解决方案。这些用户界面提供商可以控制他们部署的智能合约,使终端用户能够与 Maker 协议进行交互。最近更改 Maker Vault 30100 所有权的交易不涉及任何 MakerDAO 的官方智能合约或 MakerDAO 指令。其重申 MakerDAO 的智能合约不受 Oasis 前端智能合约的控制或控制。[2023/2/26 12:29:44]

所以如果ViT和CNN一样有视觉属性就好了!

Coinbase股价创下历史新低:金色财经报道,市场数据显示,周一美股开盘后,加密货币交易所Coinbase(COIN)股票创下历史新低,跌至39.65美元,该数字较8月初的98美元下跌了60%,当时该交易所因与贝莱德合作的消息而经历了短暂的反弹,过去一年该股已下跌83%。

此前消息,Coinbase首席执行官Brian Armstrong上周在一次采访中表示,该交易所2022年的收入将比2021年减少50%甚至更多。[2022/12/13 21:40:04]

最近MetaAI就提出了一个新模型,用attentionmap来增强卷积神经网络,说简单点,其实就是用了一个基于注意力的层来取代常用的平均池化层。

仔细一想,池化层和attention好像确实很配啊,都是对输入信息的加权平均进行整合。加入了注意力机制以后的池化层,可以明确地显示出不同patch所占的权重。

《富爸爸穷爸爸》作者:所有市场都在崩溃,包括股票、比特币等:金色财经报道,《富爸爸穷爸爸》作者罗伯特·清崎(Robert Kiyosaki)警告称,所有市场都在崩溃,特别是房地产、股票、黄金、白银和比特币。(News.Bitcoin)[2022/8/29 12:55:07]

并且与经典ViT相比,每个patch都会获得一个单一的权重,无需考虑多层和多头的影响,这样就可以用一个简单的方法达到对注意力可视化的目的了。

在分类任务中更神奇,如果对每个类别使用不同颜色进行单独标记的话,就会发现分类任务也能识别出图片中的不同物体。

基于Attention的池化层

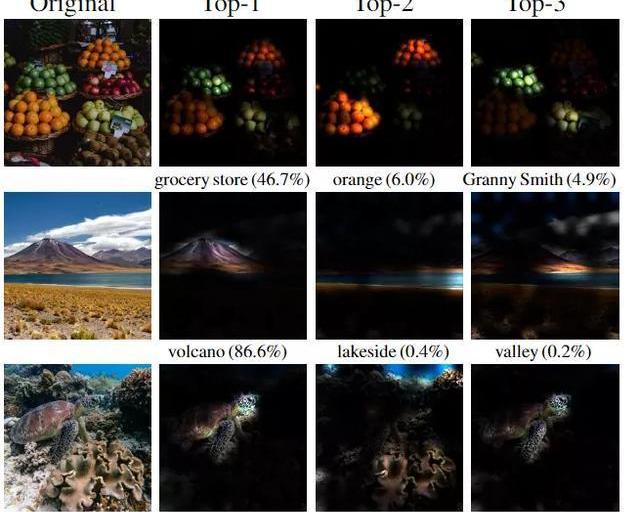

文章中新提出的模型叫做PatchConvNet,核心组件就是可学习的、基于attention的池化层。

StarkNet生态NFT市场Aspect发布测试网API:6月26日,据官方消息,基于StarkNet的NFT交易市场Aspect(前PlayOasis)近日已发布测试网API。

据悉,Aspect API是基于REST的API,在StarkNet上提供NFT数据。[2022/6/26 1:32:30]

模型架构的主干是一个卷积网络,相当于是一个轻量级的预处理操作,它的作用就是把图像像素进行分割,并映射为一组向量,和ViT中patchextraction操作对应。

最近也有研究表明,采用卷积的预处理能让模型的性能更加稳定。

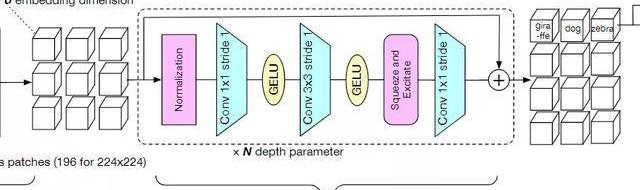

模型的第二部分column,包含了整个模型中的大部分层、参数和计算量,它由N个堆叠的残差卷积块组成。每个块由一个归一化、1*1卷积,3*3卷积用来做空间处理,一个squeeze-and-excitation层用于混合通道特征,最后在残差连接前加入一个1*1的卷积。

国际清算银行:过去对加密货币的警告已经成为现实:6月21日消息,国际清算银行表示,加密货币市场的问题应该是可控的,但还有很多未知数。过去对加密货币的警告已经成为现实。有关央行数字货币的互操作性标准可能在两年内出台。(新浪财经)[2022/6/21 4:43:15]

研究人员对模型块的选择也提出了一些建议,例如在batchsize够大的情况下,BatchNorm往往效果比LayerNorm更好。但训练大模型或者高分辨率的图像输入时,由于batchsize更小,所以BatchNorm在这种情况下就不太实用了。

下一个模块就是基于注意力的池化层了。

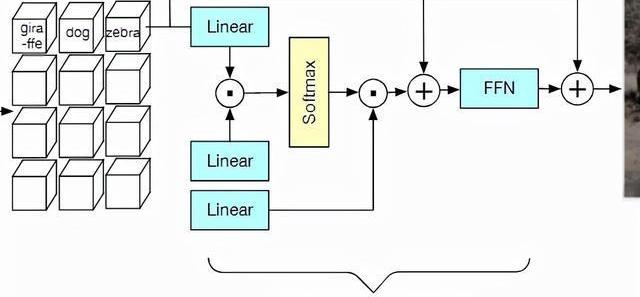

在主干模型的输出端,预处理后的向量通过类似Transformer的交叉注意力层的方式进行融合。

注意力层中的每个权重值取决于预测patch与可训练向量之间的相似度,结果和经典ViT中的classtoken类似。

然后将产生的d维向量添加到CLS向量中,并经过一个前馈网络处理。

与之前提出的class-attentiondecoder不同之处在于,研究人员仅仅只用一个block和一个head,大幅度简化了计算量,也能够避免多个block和head之间互相影响,从而导致注意力权重失真。

因此,classtoken和预处理patch之间的通信只发生在一个softmax中,直接反映了池化操作者如何对每个patch进行加权。

也可以通过将CLS向量替换为k×d矩阵来对每个类别的attentionmap进行归一化处理,这样就可以看出每个块和每个类别之间的关联程度。

但这种设计也会增加内存的峰值使用量,并且会使网络的优化更加复杂。通常只在微调优化的阶段以一个小的学习率和小batchsize来规避这类问题。

实验结果

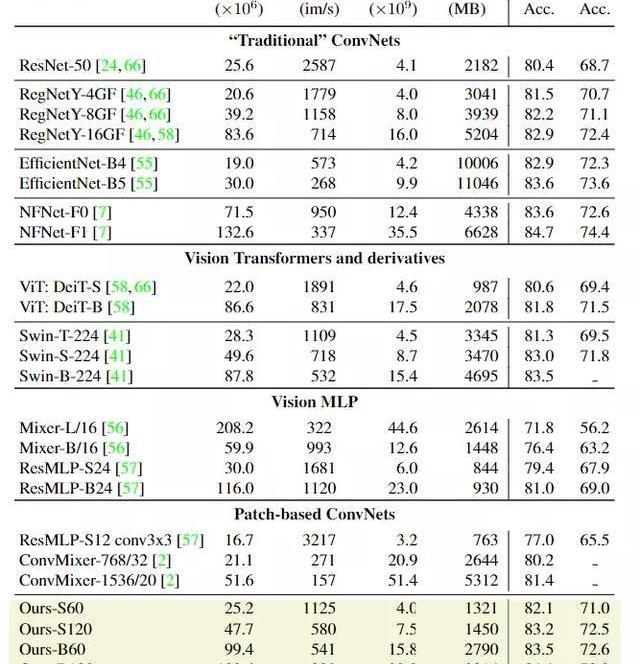

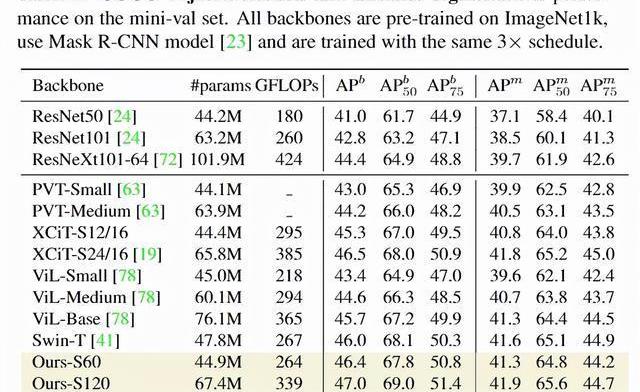

在图像分类任务上,研究人员首先将模型与ImageNet1k和ImageNet-v2上的其他模型从参数量,FLOPS,峰值内存用量和256张图像batchsize下的模型推理吞吐量上进行对比。

实验结果肯定是好的,可以看到PatchConvNet的简单柱状结构相比其他模型更加简便和易于扩展。对于高分辨率图像来说,不同模型可能会针对FLOPs和准确率进行不同的平衡,更大的模型肯定会取得更高的准确率,相应的吞吐量就会低一些。

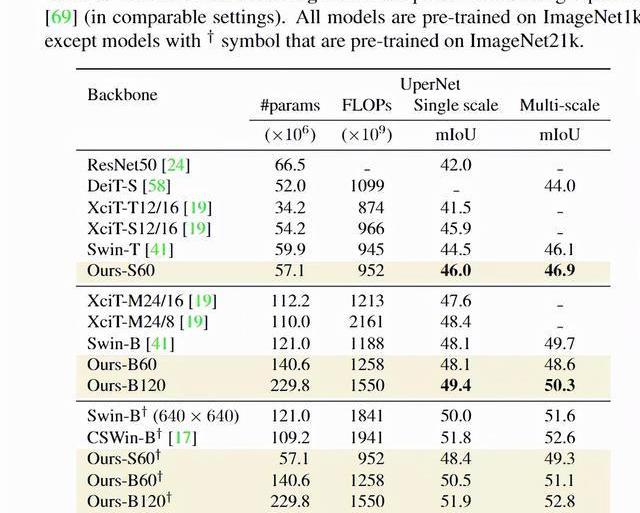

在语义分割任务上,研究人员通过ADE20k数据集上的语义分割实验来评估模型,数据集中包括2万张训练图像和5千张验证图像,标签超过150个类别。由于PatchConvNet模型不是金字塔式的,所以模型只是用模型的最后一层输出和UpperNet的多层次网络输出,能够简化模型参数。研究结果显示,虽然PatchConvNet的结构更简单,但与最先进的Swin架构性能仍处于同一水平,并且在FLOPs-MIoU权衡方面优于XCiT。

在检测和实例分割上,研究人员在COCO数据集上对模型进行评估,实验结果显示PatchConvNet相比其他sota架构来说,能够在FLOPs和AP之间进行很好的权衡。

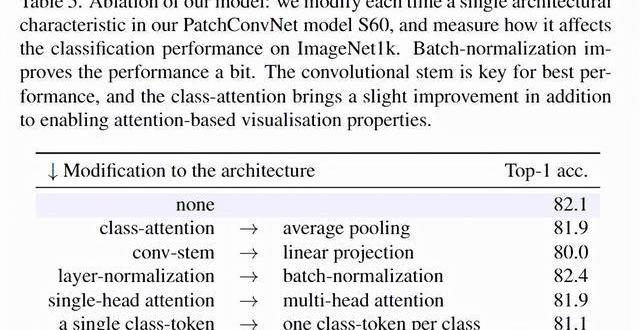

在消融实验中,为了验证架构问题,研究人员使用不同的架构对比了Transformer中的classattention和卷积神经网络的平均池化操作,还对比了卷积主干和线性投影之间的性能差别等等。实验结果可以看到卷积主干是模型取得最佳性能的关键,class-attention几乎没有带来额外的性能提升。

另一个重要的消融实验时attention-basedpooling和ConvNets之间的对比,研究人员惊奇地发现可学习的聚合函数甚至可以提高一个ResNet魔改后模型的性能。

通过把attention添加到ResNet50中,直接在Imagenet1k上获得了80.1%的最高准确率,比使用平均池化层的baseline模型提高了+0.3%的性能,并且attention-based只稍微增加了模型的FLOPs数量,从4.1B提升到4.6B。

参考资料:

https://arxiv.org/abs/2112.13692

黑龙江省哈尔滨市九中2021-2022学年高二上学期期末 语文试题 一、非连续性文本阅读 阅读下面的文字,完成下面小题.

1900/1/1 0:00:001月21日,H&M因劣质服装太阳镜被罚13万,再次冲上热搜。 1月21日,记者从上海市市场监督管理局官网获悉,近日,H&M关联公司海恩斯莫里斯商业有限公司,因其生产、销售劣质服装.

1900/1/1 0:00:00TIPS 1、下载IT桔子APP,实时跟踪国内外一级市场投融资事件。2、转载请注明来源自IT桔子,侵权必究。3、建立“投资速递”长期发布合作,请发邮件到hello@itjuzi.com.

1900/1/1 0:00:00从“汉语盘点2021”的权威活动中我们可以直观看到过去一年的流行趋势,“元宇宙”应该是唯一一个既是2021年度字词,也是2021年度十大网络用语的词汇,透过这一活动.

1900/1/1 0:00:00行业主要上市公司:道明光学(002632)、星华反光(301077)、领航科技(831706)、苏大维格(300331)、水晶光电(002273)等本文核心数据:反光材料专利申请数量、专利区域分.

1900/1/1 0:00:00来源|01区块链 作者|ChenglinPua最近一年元宇宙可以说是赚足了噱头,频频成为焦点。Meta公司的“AllIn”策略,微软的进军以及英伟达想要打造元宇宙的基建等,都将元宇宙的热度拉上一.

1900/1/1 0:00:00