编辑部整理自MEET2021量子位报道|公众号QbitAI

人工智能,现在发展到什么阶段了?

从发展脉络上看,从符号智能、感知智能,现在应该到认知智能阶段了。

或者说,我们正走在认知智能的路上。

今年大火的GPT-3,其参数量已然达到了千亿级别,规模已经接近人类神经元的数量了。

这说明,GPT-3的表示能力已经接近人类了,但它仍有一些认知局限——没有常识。

那我们何时、又将如何走向认知智能?

未来计算机的认知能力,能否超过人类?

什么样的模型可以驱动未来的认知AI?

认知智能的概念是否又该重新定义?

……

在MEET2021智能未来大会现场,清华大学计算机系教授、系副主任唐杰用简单、通俗的例子为我们一一解答。

当时听完演讲的观众直呼:求唐杰老师的PPT!

关于MEET智能未来大会:MEET大会是由量子位主办的智能科技领域顶级商业峰会,致力于探讨前沿科技技术的落地与行业应用。本次大会现场有李开复等20余位行业顶级大咖分享,500余名行业观众参与,超过150万网友在线收看直播。包括新华社、搜狐科技、澎湃新闻、封面新闻等数十家主流媒体在内纷纷报道,线上总曝光量累计超过2000万。

亮点

1、认知图谱有了一个全新概念,它包含三个核心要素:常识图谱、逻辑生成以及认知推理。

2、GPT-3参数规模已经接近人类神经元的数量,这说明它的表示能力已经接近人类了。但是它有个阿喀琉斯之踵——没有常识。

3、数据+知识双重驱动,也许是解决未来认知AI的一个关键。

4、用计算模型来解决认知是不够的,未来需要构建一个真正能够超越原来的,超越已有模型的一个认知模型。

5、通用人工智能还有多远?我们希望它有持续学习的能力,能从已有的事实,从反馈中学到新的东西,能处理一些更复杂的任务。

清华大学:当前元宇宙产业面临十大潜在风险:12月6日消息,在“中国发展高层论坛青年企业家峰会”上,清华大学新闻学院新媒体研究中心执行主任沈阳介绍了该团队撰写的《2020-2021年元宇宙发展研究报告》。沈阳表示,元宇宙是目前可见的移动互联网的终极形态,但由于元宇宙产业还处于初期发展阶段,具有新兴产业的不成熟、不稳定等特征,存在多重潜在风险。当前元宇宙产业整体处于“亚健康”状态,至少存在十大风险点,亟待产业和市场回归理性。这十大风险点分别是资本操纵、舆论泡沫、伦理制约、垄断张力、产业内卷、算力压力、经济风险、沉迷风险、隐私风险和知识产权保护问题。(163.com)[2021/12/6 12:52:52]

为什么是认知图谱

我给今天的分享起了一个新名字:“认知图谱:人工智能的下一个瑰宝”。

为什么叫认知图谱?首先看一下人工智能发展的脉络。

从最早的符号智能,再到后面的感知智能。最近,所有人都在谈论认知智能。

我们现在需要探讨“计算机有没有认知”、“计算机能不能做认知、推理”、“计算机到未来有没有意识,能够超过人类”这些问题。

人工智能发展到现在已经有三个浪潮,我们把人工智能叫做三个时代分别是符号AI、感知AI和认知AI,现在正处在实现认知AI的路上。

具体如何实现呢?

我认为需要一些基础性的东西,比如里面的认知图谱怎么构建,里面认知的一些逻辑,包括认知的基础设施怎么建,这也是我们特别想做的一件事情。

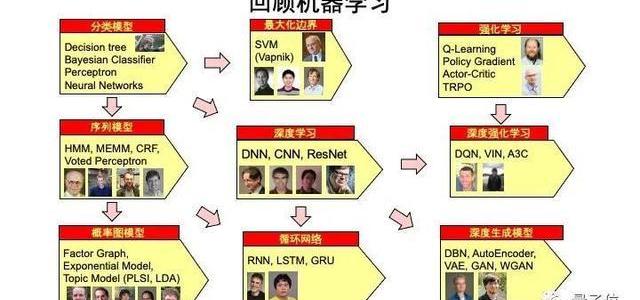

回顾机器学习的发展历程,首先想到的就是很多分类模型,比如决策树,贝叶斯、神经网络……

最左边是分类模型、序列模型、概率图模型,往右一点是最大化边界,深度学习,循环智能,随后是强化学习、深度强化学习,以及最近常提及的无监督学习。

机器思考VS人类思考

声音 | 清华大学经管学院副教授:金融交易是区块链的天然应用场景:11月19日,在由经济观察报社、新金融家联盟联合主办的“区块链金融应用前景与挑战研讨会”上,清华大学经管学院副教授、中国金融研究中心副主任朱英姿从金融角度探讨了区块链在金融交易场景中的应用。

朱英姿表示,金融交易是区块链的天然应用场景。区块链的特性,与金融交易之间要解决金融交易痛点“非常吻合”,但其也指出,区块链并非能够解决所有问题,但的确能够通过降低交易成本来提高交易效率。

“区块链不能解决所有问题,只能解决一部分的问题,例如它不能解决是否这个市场可以存在,是否这些交易各方有动力来参加等问题。”朱英姿表示,“但是区块链能够用技术方式推行行业标准,规范行业乱象,确实解决了这个行业极大的痛点。”(经济观察报)[2019/11/23]

机器学习发展到现在,离认知到底还有多远?

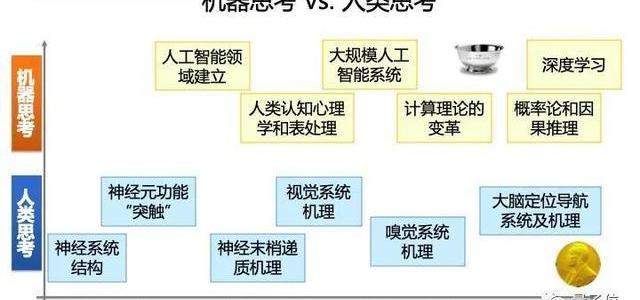

于是,我整理了很多诺贝尔奖和图灵奖得主的研究,对比了人的认知与机器认知之间的发展模式。

在探究人类思考的历程里,1900年初才有了神经系统结构的第一次解析,随后在1932年左右,诞生了一个诺奖级的研究:神经元功能“突触”。

然后就是神经末梢传递机制、视觉系统机理、嗅觉系统机理……直到几年前,科学家们才探索出人的大脑是如何实现定位导航、以及机理是怎么回事,这也是一个诺奖的研究。

我们来看下机器是如何思考的。

1950年左右,学者创立了人工智能系统,但是1970年左右大家开始拼命去模仿人脑,我们要做一个计算机,让他跟人脑特别相同。

1990年左右,科学家突然发现其实没有必要模仿,更多的应该是去参考人脑,参考脑系统,做一个有更多机器思考、机器思维的计算机。

所以在当前这个时代,我们应该用更多的计算机思维,来做计算机的思考,而非人的思考。

因此在这之后,就出现了概率图模型、概率与因果模型以及深度学习。当然,有人会说,到最后你还在讲机器学习,在讲一个模型,这个离我们真正的认知智能是不是太远了?

声音 | 清华大学胡志琳博士:可信技术结合跨链技术为公链与联盟链互通提供安全保障:Trias首席算法科学家胡志琳博士在参加BlockMania主办的「博士大爆炸」AMA分享时表示,将公链和联盟链互通,能够使它们的优势得以互补。可信技术结合跨链技术为公链与联盟链互通提供安全保障。

负一层网络技术可以通过提供网络节点可信以及网络间的可信跨域,简化和支持在公链生态下开发者所贡献的跨链技术,各条联盟链之间的资产转移可以通过链上SPV智能合约进行。同时各条联盟链还互相引用彼此的默尔克树,降低攻击成功的可能性。通过Merkle roots 共享信息实现跨链共识,连接多条联盟链分担计算负载。[2019/11/2]

用计算的方式打造通用人工智能

过去几年连我自己都不信,我们可以建造一个通用人工智能,让计算机系统甚至能够超越人。

举一个例子,OpenAI。

两年前,OpenAI做了**GPT,所有人都觉得只是一个很简单的语言模型,并不会有什么水花;

去年,GPT升级成GPT-2,15亿的参数规模。很多人都可能玩过它的Demo,叫talktotransformer。你可以输入任何文本,transformer帮你把文本补齐。

但在今年6月份的时候,OpenAI发布了一个GPT-3,参数规模一下子达到了1750亿,数量级接近人类的神经元的数量。

这个时候给我们带来了极大的震撼,至少说明GPT-3的表示能力已经接近人类了。

意味着理论上,如果我们能让计算机参数达到最好,GPT-3可能跟人这种智商表现差不多。

这时候给我们另外一个启示:

我们到底是不是可以直接通过计算机的结果,也就是计算的方法得到一个超越人类的通用人工智能?

我们来看一下整个模型过去几年发展的结果,几乎每年参数规模是10倍左右的增长,右边的图给出了自然语言处理中最近几年的快速变化,几乎是一个指数级的变化。

可以看到,前几年变化相对比较小,今年出了GPT-3,谷歌到了6000亿的产出规模,明年ds可能还会到万亿级别。所以这是一个非常快速的增长。

声音 | 清华大学何平:区块链技术还处于不断完善的阶段,产学研融合是其中的重要一环:清华大学经管学院教授何平强调区块链不能解决所有问题,它同任何一项技术一样需要有个不断升级的过程。目前的区块链技术还没有完全成熟,比如去中心化程度与效率之间的矛盾就是缺陷之一,既然交易速度受限,那么这是不是意味着区块链应该先应用于一些低频交易?这都是值得探讨的问题。何平还提到,当产业由少数利益相关者推动时,要警惕它对于整个社会的利益来讲不见得是最有效的,应该从整体上把握一门技术的效率方向,以及对于社会财富再分配的影响,不能任由产业盲目发展。总体来说,何平认为区块链技术还处于不断完善的阶段,产学研融合是其中的重要一环。点对点的互信交易是区块链最大的价值所在,学院派在其中应该先进行理论研究,尽可能的为行业提供更加科学和通用的标准。[2019/5/15]

现在,则给到我们另外一个问题,

我们到底能不能用这种大规模、大算力的方法,大计算的方法,来实现真正的人工智能呢?

与此同时,也暴露出另一个痛点——成本问题。

GPT-3,如果用单卡的训练需要355年,整个训练成本将达到几亿人民币,一般的公司是做不起来的。

但就算是有互联网巨头愿意去做,大家是不是都可以用了?

GPT-3有个阿喀琉斯之踵

不着急。先来看看这样一个例子,左边是GPT-3模型,右边是结果。

第一个是长颈鹿有几个眼睛?GPT3说有两个眼睛,没有问题。

第二个问题,我的脚有几个眼睛?结果是也有两个眼睛,这就错了。

第三个,蜘蛛有几个眼睛?8个眼睛。

第四个太阳有几个眼睛?一个眼睛。

最后一个问题,一根草有几个眼睛?一个眼睛。

可以看到,GPT3很聪明,可以生成所有的结果,但它有个阿喀琉斯之踵——没有常识。

清华X-lab区块链实验室正式启动:今日,清华X-lab成立5周年并成立区块链实验室,致力于区块链领域的研究。火币集团旗下火币Labs与清华X-lab正式签约合作,启动“清华x-lab区块链实验室”,共同推动区块链行业的发展。火币集团COO朱嘉伟、火币Labs合伙人阙小耕、清华X-lab主任毛东辉及区块链实验室发起人夏立参加启动仪式,金色财经是本次区块链实验室的支持单位。[2018/5/26]

这时候就需要一个常识的知识图谱。

2012年,谷歌发出了一个KnowledgeGraph,就是知识图谱。

当时的概念是,我们利用大量的数据能不能建一个图谱?于是在未来的搜索中,可以自动把搜索结果结构化,自动的结构化的数据反馈出来。

知识图谱不仅可以应用到搜索引擎,还可以给计算机带来一些常识性的知识。

因此,我们是否可以通过这一方法来帮助未来的计算呢?

「数据+知识」驱动未来的认知AI

其实,知识图谱在很多年前就已经发展起来。

从第一代人工智能——符号AI的时候,就已经开始在做,当时将知识图谱定义为“符号AI的逻辑表示”。

但到现在也还没有大规模的发展起来,主要有几个方面的原因。

第一,构建的成本非常的高。

CYC,最早的知识图谱之一,负责定义知识断言。

简单来说就是,一个ABC三元组,A就是主体,B就是关系,C是受体。

比如,人有手,人就是主体,有就是关系,手就是受体。

这么一个简单的问题,成本就在5.7美元。

第二,自动构建精度很低。

另一个典型的知识图谱NELL,互联网完全自动方法的生成出来,但错误率一下子提高到10倍。

这两个项目目前基本上都处于半停滞状态。

于是,我们现在就在思考,若是将上述两种方式结合在一起,是否能够驱动认知AI?

第一,从大数据的角度,做数据驱动。用深度学习举十反一的方法,把所有的数据进行建模,并且学习数据之间的关联关系,学习数据的记忆模型。

第二,我们要用知识驱动,构建一个知识图谱,用知识驱动整个事情。

我们把两者结合起来,这也许是解决未来认知AI的一个关键。

当然这些也还不够。我们的未来是需要构建一个真正能够超越原来的、已有模型的一个认知模型。

我们需要一个全新的架构框架,也需要一个全新的目标函数,这时候才有可能超过这样的预训练模型,否则就是在跟随GPT-3。

而放在眼下要做的,就是让机器有一定的创造能力,光文本还不够,我们希望创造出真正的图片,它是创造,不是查询。

比如,机器可以通过文字,将原有的图片生成新的图片。

当然,光创造还不够,我们离真正通用的人工智能还有多远?

我们希望真正的通用人工智能有持续学习的能力,能够从已有的事实,从反馈中学习到新的东西,能够完成一些更加复杂的任务。

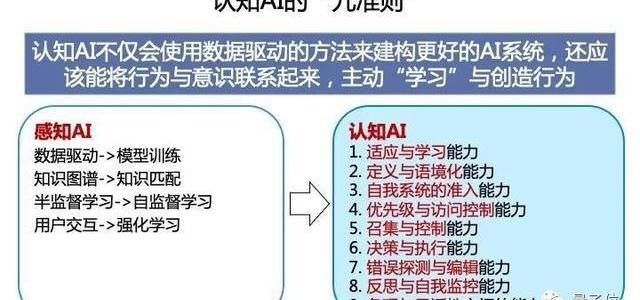

认知AI的九准则

这时候,再回到起初最基本的问题:什么叫认知?

只要有可持续学习的能力就是认知吗?

如果这样的话,GPT-3也有持续学习的能力,知识图谱也有学习的能力,因为它在不停的更新。

如果能完成一些复杂任务就是认知吗?

也不是,我们已经有些系统已经可以完成非常复杂的问题。

那什么是认知呢?

最近,通过我们的一些思考,定义了认知AI的九准则。这九个准则是我从人的认知和意识中抽象出来的九个准则。

第一个,叫适应与学习能力。

比如说今天MEET大会,机器人自动学习,可以知道在这个特定的场景下应该做什么事情。

第二个,叫定义与语境能力。

模型能够在特定语境下感知上下文,对环境有一定的感知能力。

第三个,叫自我系统的准入能力。

机器能够自定义什么是我,什么是非我,这叫人设。如果这个机器能知道自己的人设是什么,那么我们认为它有一定的认知能力。

第四个,优先级与访问控制能力。

在一定的特定场景下它有选择的能力。我们人都可以在双十一选择购物,如果机器在双十一的时候能选择我今天想买点东西,明天后悔了,不应该买。

这时候机器有一定的优先级和访问控制。

第五个,召集与控制能力。这个机器应该有统计和决策的能力。

第六个,决策与执行能力,机器人在感知到所有的数据以后可以做决策。

第七个,错误探测与编辑能力。

这个非常重要,人类的很多知识都在试错中发现的。比如现在学的很多知识,我们并不知道什么知识是最好的。

我们需要不停的试错,也许我们今天学到了1+1=2是很好,但是你尝试1+1=3,1+1=0,是不是也可以呢?你尝试完了发现都不对,这叫做错误探测与编辑,让机器具有这个能力,非常地重要。

第八个,反思与自我控制、自我监控。

如果这个机器人在跟你聊天的过程中,聊了很久,说“不好意思我昨天跟你说的一句话说错了,我今天纠正了。”这时候机器具有反思能力。

最后,这个机器一定要有条理和理性。

一个面向认知的AI架构

在九个准则的基础上,我们提出了一个全新的认知图谱的概念。

主要有三个核心要素。

第一个,常识图谱,这与知识图谱的几个要素非常相关。比如说高精度知识图谱的构建、领域知识图谱的应用系统、超大规模知识图谱的构建,还有基于知识图谱的搜索和推荐,这是传统的一些东西。

第二个,逻辑生成。这需要超大规模的预训练模型,并且能够自动进行内容生成。同时我们在未来可以构建一个数字人的系统,它能够自动的在系统中,能够生成相关的东西,能够做得像人一样的数字人。

第三个,认知推理。让计算机有推理、有逻辑的能力。

这时候说起来比较虚,用人的认知来通俗理解一下。

人的认知有两个系统,一个叫系统1,一个叫系统2。

系统1就是计算机做的匹配。

你说,清华大学在哪?它便立刻匹配出来北京。

但如果你要是问,清华大学在全球计算机里到底排第几?以及为什么是这个名次?

这时候计算机就回答不了,这就需要一定的逻辑推理,也就是系统2所做的事情。

当前所有的深度学习都是做系统1,解决了系统1问题——直觉认知,而不是逻辑认知。

因此在未来,我们要做更多关于系统2的事情。

从脑科学来看,相对现在做的事情有两个最大的不同,第一,就是记忆,第二就是认知推理。

记忆是通过海马体实现,认知是前额叶来实现。这两个系统非常关键,如何实现呢?

我们看记忆模型,巴德利记忆模型分三层,短期记忆就是一个超级大的大数据模型。

在大数据模型中,我们怎么把大数据模型中有些信息变成一个长期记忆变成我们知识,这就是记忆模型要做的事情。

那认知模型呢?我们构建了一个面向认知的AI架构。

这个框架左边是一个查询接口,这是输入,也可以说成是用户端。

中间是一个超大规模的预训练模型,然后是一个记忆模型。

记忆模型通过试错、蒸馏,把一些信息变成一个长期记忆存在长期记忆模型中。

长期记忆模型中会做无意识的探测,也会做很多自我定义和条理的逻辑,并且做一些认知的推理。

在这样的基础上我们构建一个平台。最终目标是打造一个知识和认知推理双轮驱动的一个框架。底层是分布式的存储和管理,中间是推理、决策、预测,再上面是提供各式各样的API。

好,我今天大概就把我们的理念和想法给大家介绍一下,如果大家有兴趣的话,可以查阅我们更多的信息。

谢谢大家!

标签:GPT人工智能MEETGPT价格GPT币人工智能技术应用学人工智能后悔死了人工智能考研考哪些科目MEET价格MEET币

来源:时代周报 消失的比特币 时代周报特约记者侯明钰 如果号称安全、加密的比特币在互联网上永远消失呢?美剧《硅谷》有这样一幕:一位富翁焦躁地在垃圾山上挖掘,试图找到一个丢失的U盘.

1900/1/1 0:00:00来源:新浪财经 2019年竞拍巴菲特午餐而闻名的中国加密货币企业家孙宇晨周三表示,随着年轻人涌入金融资产,投资领域将发生范式转变.

1900/1/1 0:00:00XRPXRP/BTC交易对从2月1日非常强劲的下跌图表来看,Ripple在2月5日形成上涨趋势,该市场形成了以0.00001BTC水平为支撑线的区间市场.

1900/1/1 0:00:00新华社纽约1月14日电比特币价格近日大涨,接连突破3万美元和4万美元整数关口,备受市场关注。分析人士认为,比特币价格上涨受机构投资者入场及国际金融市场资金充裕等因素带动.

1900/1/1 0:00:00词根col(1)来源于拉丁动词colere"totill耕种",常见的变体形式cult(colere的过去分词形式cultus),fromPIEroot*kwel-(1)"revolve.

1900/1/1 0:00:00比特币总市值超过特斯拉,位列全球资产第七位。比特币合约全网25万人爆仓据比特币家园网数据,截至2月15日20:30,比特币合约全网24小时内超过25万人爆仓,合计爆仓金额达到15.81亿美元,约.

1900/1/1 0:00:00